- Aktivkohlefilter (5,50 €)

- Wippschalter (2,10 €)

- Batterieclip (1 €)

- Batteriehalter 8 x AA (7,50 €)

- 8 x AA-Batterien (~1,50 €)

- Klettband zum Kleben (1 €)

- 4 x M4 Schrauben + Muttern (~0,40 €)

- 1 Tube Sekundenkleber (~1 €)

- ~130 mm² 3 mm dickes Sperrholz Pappel zum lasern (3~9 €)

- E-Mail: FairEmail

- Browser: Fennec (Firefox Fork)

- Messenger: Element (Matrix), Telegram FOSS, Signal (wird von CalyxOS bereit gestellt) / Molly

- Bilder: Simple Gallery

- Password Manager: AuthPass, KeePassDX, Bitwarden

- 2FA OTP: Aegis Authenticator, andOTP, Bitwarden

- Tastatur: FlorisBoard, OpenBoard

- YouTube: NewPipe

- Kalender/Kontakte Syncronisierung: DAVx⁵

- VPN: WireGuard, Mullvad VPN

- Reddit: Slide, Infinity

- Launcher: Discreet Launcher, Posidon Launcher

- Maps: OsmAnd~

- Manga Reader: Tachiyomi, Hendroid

- QR Code Scanner: QR & Barcode Scanner

- Video Player: mpv-android, VLC

- SFTP Server: primitive ftpd

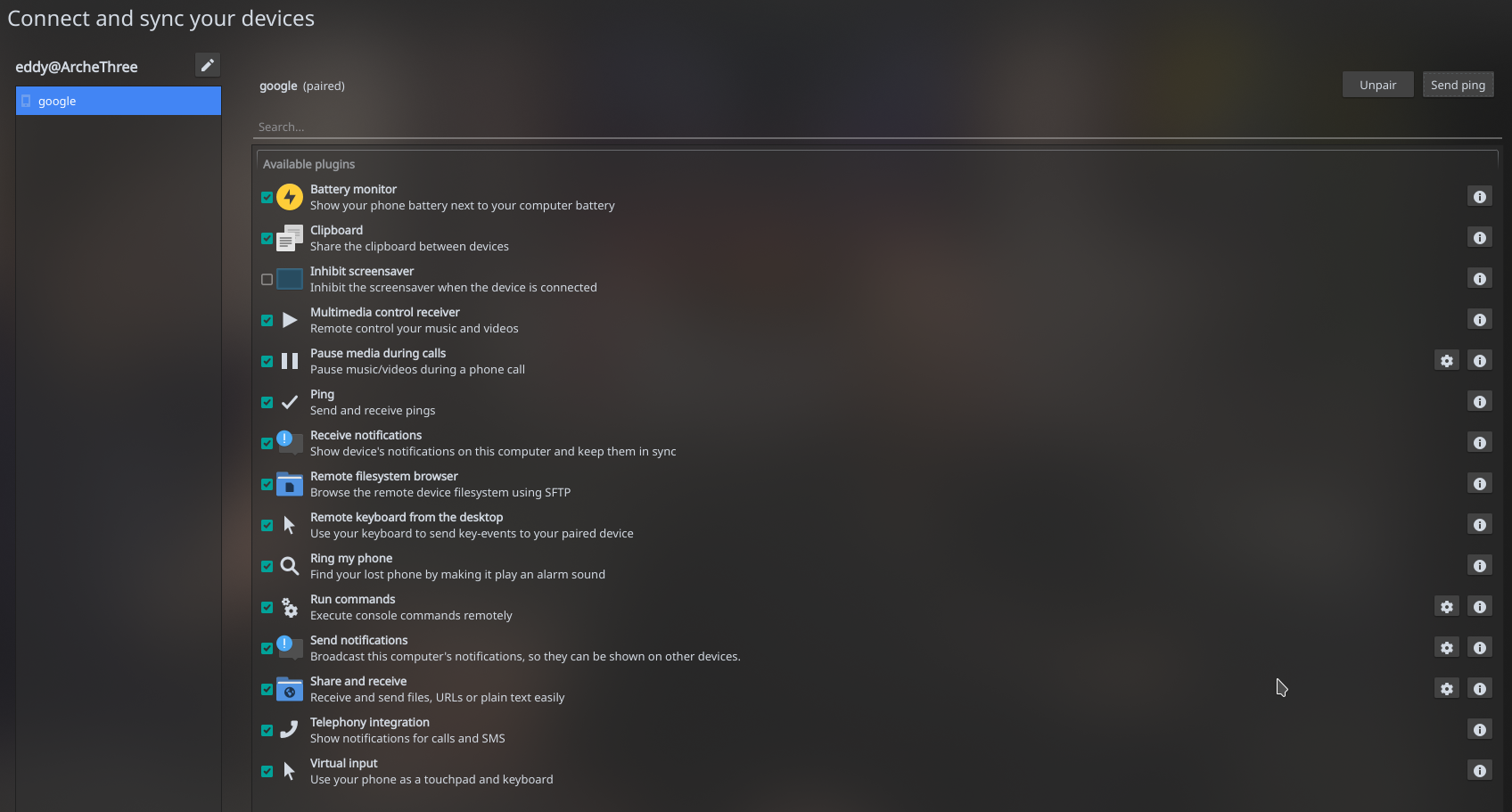

- PC Notification Sync: KDE Connect

- Corona Tracing: Corona Contact Tracing Germany

- Twitter: Twidere X, Fritter

- Mehr Arbeitsspeicher (2 bis 4 GB statt nur 1 GB RAM)

- Ethernet und USB Hub sind jetzt getrennt und teilen sich nicht mehr denselben USB 2.0 Bus

- Gigabit Ethernet ist damit jetzt möglich

- USB Typ-A 3.0 an zumindest zwei Buchsen möglich die direkt per PCIe Lane an dem SoC hängen

- Zwei Micro-HDMI 2.0 Ausgänge (beide bis zu 4K Auflösung) statt nur einem HDMI Ausgang

- Der neue BCM2711 SoC kann nativ H.265 Videos in 4K dekodieren

- Der Micro-SD Karten Leser ist nun schneller bei 50 MB/s statt 25 MB/s

- Trotz 64 bit ARM SoC nutzt das offizielle Raspbian nur 32 bit

- Erhöhter Stromverbrauch über die USB Typ-C Stromversorgung (15 Watt a 5V/3A) gegenüber den 12 Watt a 5V/2,5A des Vorgängers

- Micro-HDMI statt HDMI Ausgang

- Kein voller Support für andere Linux Distributionen außer Raspbian

- Kein USB Boot ab Werk

- “Grün” bedeutet, dass die Tür offen für alle ist, das wird auch auf der Webseite so öffentlich angezeigt.

- “Gelb” bedeutet, dass ein Mitglied anwesend ist, jedoch nicht im Hauptraum ist um Nicht-Mitglieder zu empfangen.

- “Rot” steht schlicht dafür das niemand anwesend ist und die Tür zuschließt, auch diesen Status findet man auf der Webseite.

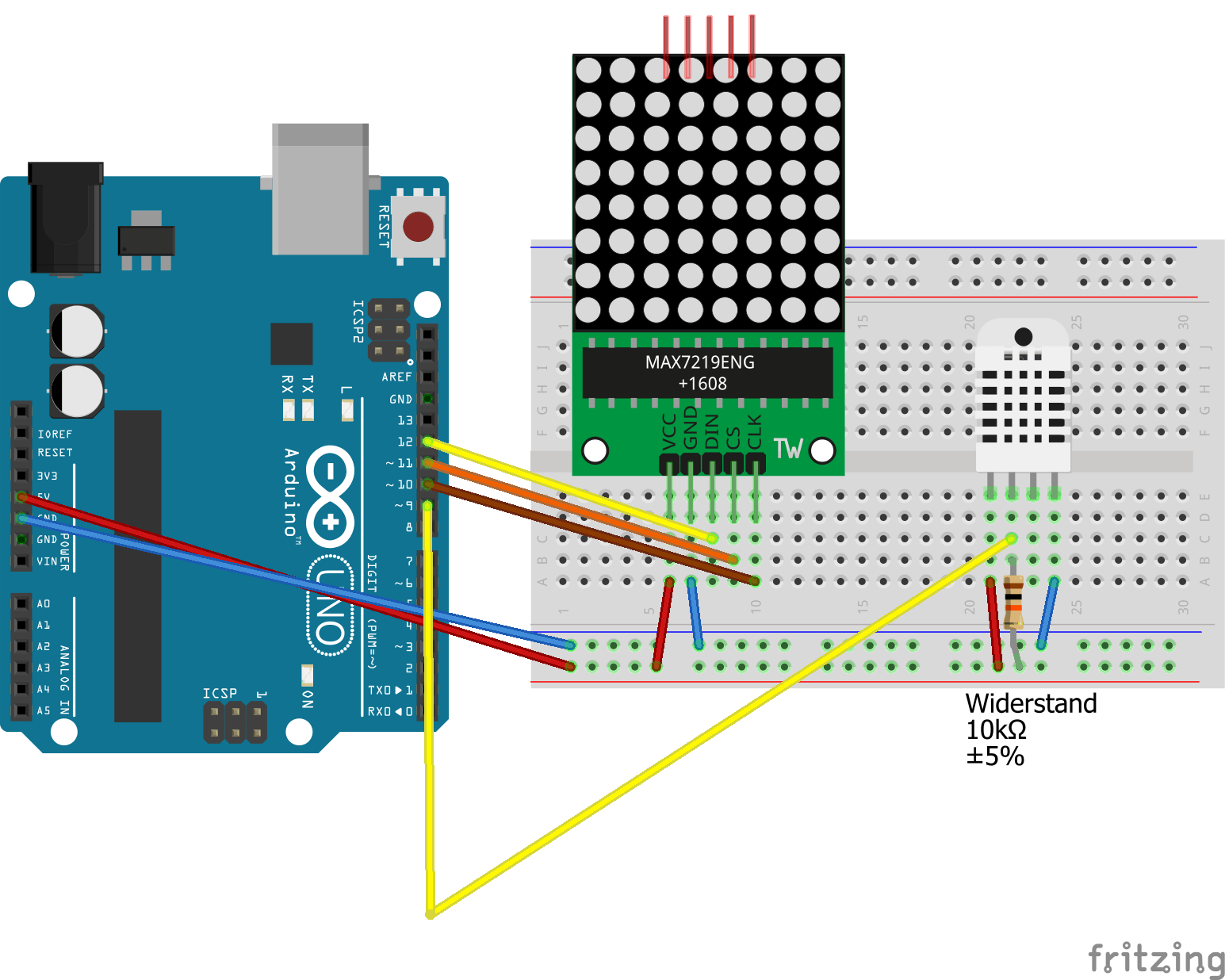

- Arduino Uno

- Breadboard (Halfsize oder Fullsize)

- DHT22 Feuchtigkeits- / Temperatur-Sensor

- 10kΩ Widerstand (für den Data-Pin vom DHT22 Sensors)

- MAX7219 Matrix 8x8 LED Display

- 9. Februar 2016

- 26. März 2015 (Hotfix)

- 24. März 2015

- 27. August 2014

- 17. Dezember 2013

- 27. Juni 2013

- etc …

In 2014 kamen nicht nur sehr gute Anime Serien raus, sondern ich habe dieses mal meine Bücher-Sammlung extrem erweitert. In diesem Recap möchte ich in ein paar wenigen Sätzen einige dieser Titel aus 2014 ein wenig schmackhaft machen. Besonders The Apothecary Diaries, Delicious in Dungeon und Frieren: Beyond Journey’s End waren meine absoluten Anime-Highlights dieses Jahr.

Seit einigen Jahren benutze ich Jellyfin, um Serien und Filme auf meinem Fernseher einfacher ansehen zu können, theoretisch könnte ich damit auch meine Bilder-/Audio-/Buch-Sammlung sortieren, aber diese Funktion benutze ich nicht. Jellyfin ist als Fork von Emby entstanden, als Emby von Open Source zu Closed Source wurde und schon vorher damit begonnen hatte, beliebte Features hinter Bezahlschranken zu stellen. Das ist schon ein wenig ironisch. Denn Emby entstand einst als Alternative zu Plex, das seinerseits durch Bezahlschranken negativ auffiel (die Plex Mobile App ist z.B. Premium only). Für mich war die Entscheidung also ziemlich klar, auch wenn vielleicht das Feature X oder Y bei Jellyfin fehlt. Der Einfachheit halber läuft Jellyfin bei mir in einem Docker Container auf meinem Heimserver. Die gute Dokumentation erklärt aber auch andere Installationsmethoden und ist wirklich nicht so schwer wie man denkt.

Aber das eigentliche Thema dieses Blogeintrags ist ein anderes, wie fülle ich meinen Medienserver mit Videos?

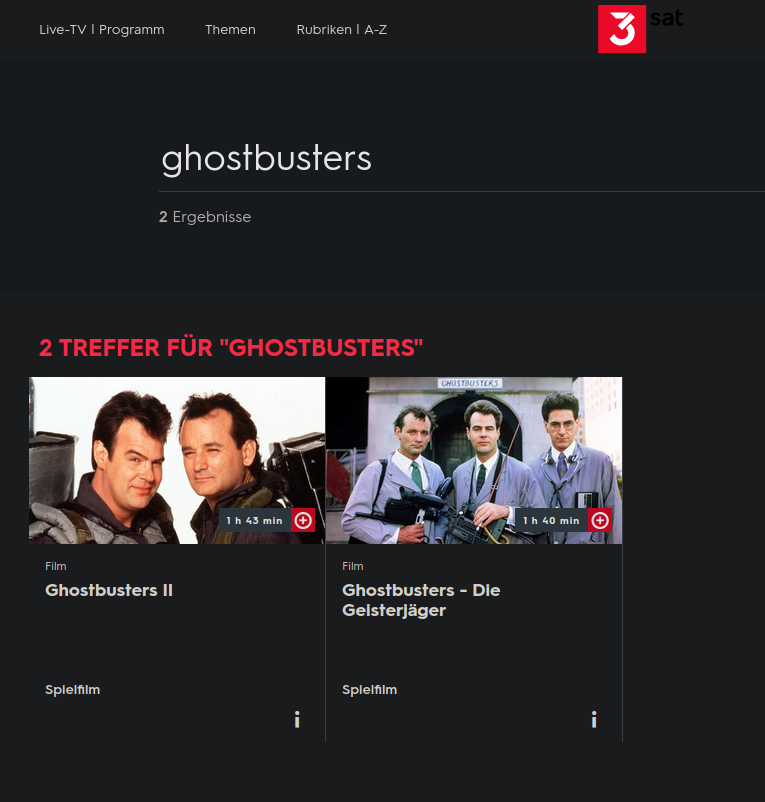

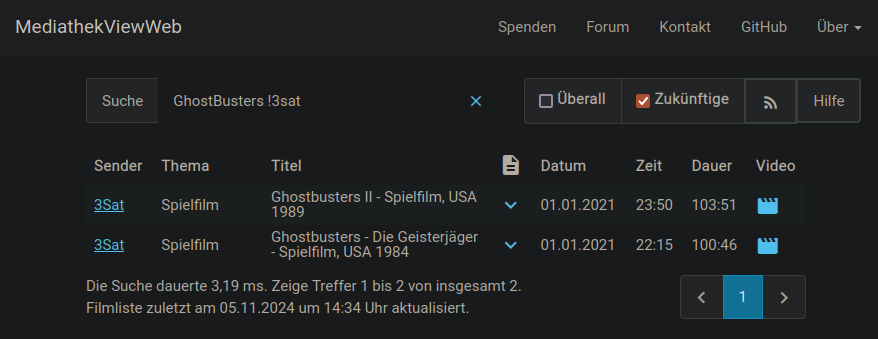

MediathekenView

Wer in Deutschland lebt, muss pro Haushalt eine monatliche Gebühr für die öffentlich-rechtlichen Rundfunkanstalten zahlen. Warum also nicht auch deren Online-Mediatheken nutzen? Besonders einfach geht das mit MediathekenView bzw. MediathekenViewWeb, mit dem man die (Video-)Mediatheken ganz einfach durchsuchen und direkt streamen oder downloaden kann. Der Download ist vor allem deshalb wichtig, weil nach dem aktuellen Rundfunkstaatsvertrag die Inhalte der Mediatheken nur zeitlich begrenzt zur Verfügung stehen dürfen. Teilweise ist dies nur für eine Woche, oft aber auch für ein Jahr.

Zum Beispiel sind in dieser Woche Ghostbusters und Ghostbusters 2 bis zum 10.11.2024 in der 3sat Mediathek verfügbar.

Aber auch Serien gibt es, z.B. Killing Eve oder Feuer & Flamme.

Leider sind die meisten Streams / Downloads nur in deutscher Sprache und ohne eingebaute Metadaten verfügbar. Zum Glück kann Jellyfin (oder ein anderer Media-Server) die Meta-Daten automatisch aus Online-Datenbanken wie IMdb, TheMoviedB oder TheTVDB beziehen und ergänzen. Ich empfehle auch die heruntergeladenen Videos direkt umzubenennen, damit der Mediaserver der Wahl die Metadaten leichter finden kann. Serien sollten am besten das Format “{Serienname} S01E01” haben, damit man sofort weiß, dass es sich um Folge 1 der ersten Staffel handelt. Wer auf dem Laufenden bleiben will, was gerade in den Mediatheken verfügbar ist, kann z.B. bei https://feddit.org/c/mediatheque vorbeischauen. Hier sammelt die Feddiverse Community interessante Titel.

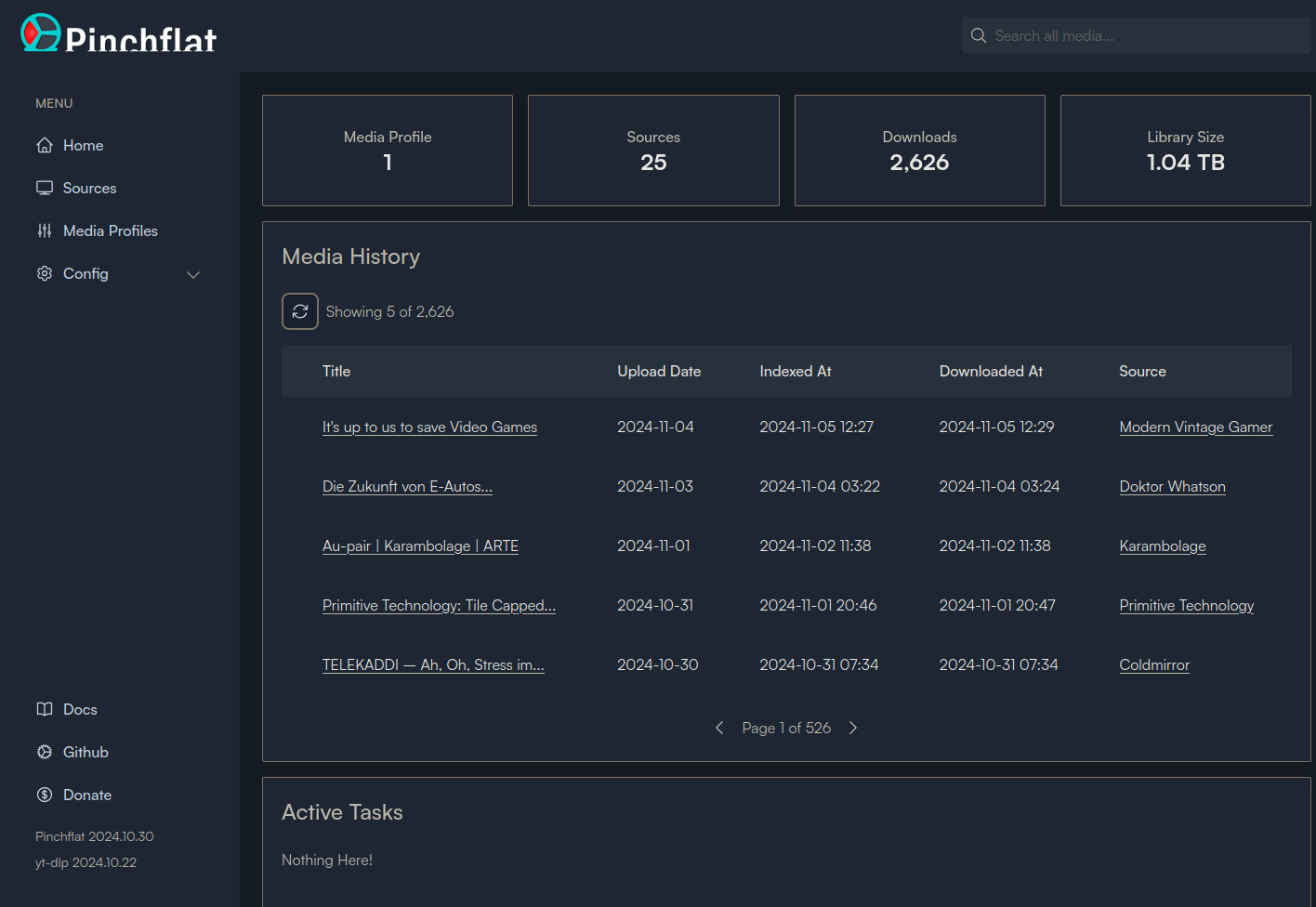

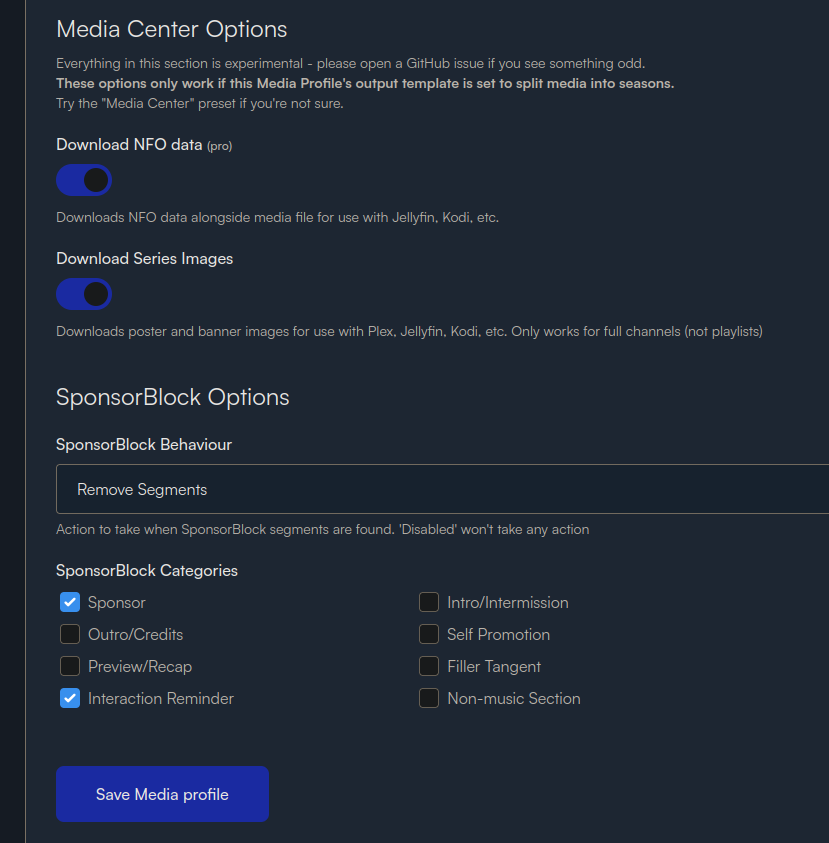

Pinchflat um Youtube anzuzapfen

Es gibt Youtube-Videos, die ich lieber auf dem Fernseher als auf dem PC als Second-Screen-Content anschaue, aber leider ist die Youtube-App auf meinem Fernseher voller Werbung und eine Datenschleuder. Abhilfe schafft hier Pinchflat. Einmal eingerichtet und mit den gewünschten Youtube-Kanälen und Playlists gefüttert, kümmert sich Pinchflat um den Download der Videos in einen definierten Ordner (in dem Jellyfin dann Ausschau hält)

Als Bonus kann man direkt Sponsorblock auf die Videos anwenden und Werbung vom Content Creator direkt rausschneiden lassen.

Damit Jellyfin die Videos nun nach Kanal-Namen mit Thumbnails anzeigt, empfele ich eine neue Library anzulegen mit dem Content Type “Music Videos”.

Privatkopie einer DVD/Blu-Ray

Mit wesentlich mehr Aufwand muss man rechnen, wenn man seine physische DVD/Blu-Ray Sammlung digitalisieren und eine Privatkopie sichern möchte. Das Problem ist hier vor allem das man einen PC mit Blu-Ray Laufwerk benötigt, die nicht gerade billig sind. Zusätzlich hat man das Problem das auf den Discs die Serien/Filme in wenig komprimierten Transport Streams (*.ts) vorliegen, die nicht immer in der richtigen Reihenfolge sind. An dieser Stelle möchte man wahrscheinlich den Stream nochmal in einen effizienteren Codec wie z.B. AV1 oder H256/HVEC vorkomprimieren, was z.B. Plex automatisch kann, Jellyfin aber nicht.

Ich möchte auch noch mal darauf hinweisen, dass es nicht erlaubt ist, Privatkopien von ausgeliehenen DVDs/Blu-Rays, z.B. aus Bibliotheken, anzufertigen.

Bonus

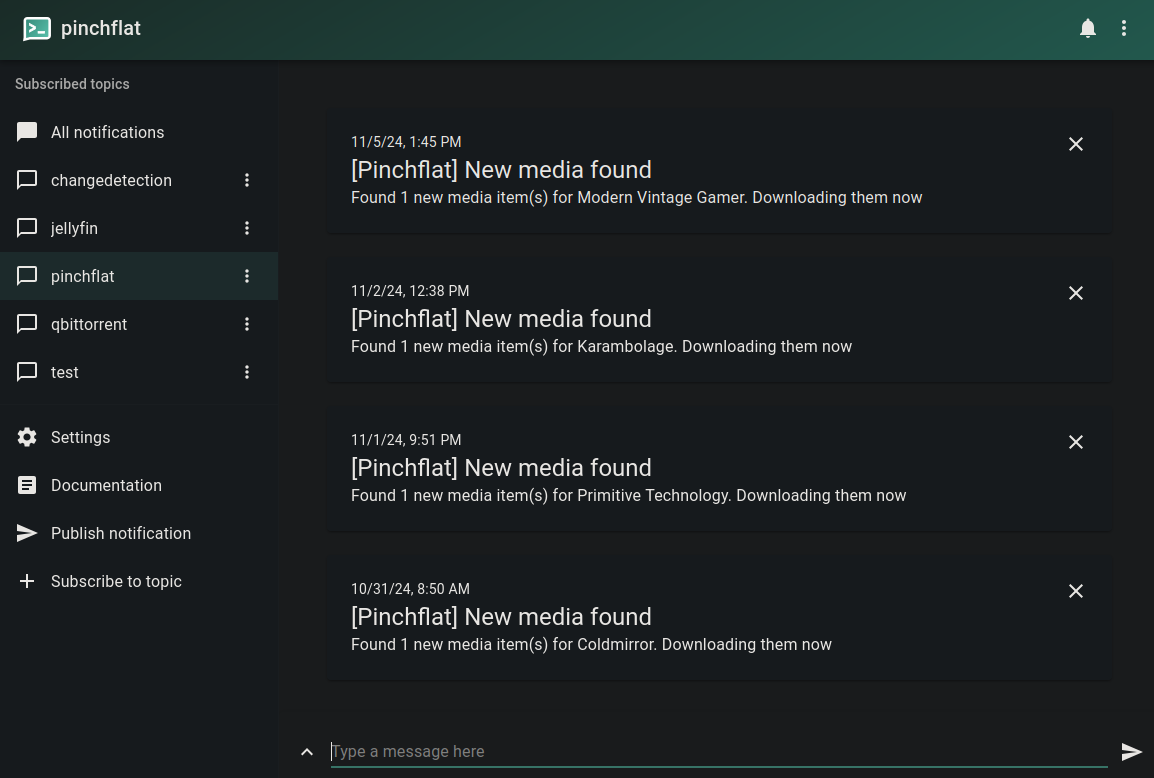

Wer informiert werden möchte, sobald neue Episoden bei Jellyfin eintreffen oder neue Youtube-Videos erscheinen, kann Jellyfin und Pinchflat mit ntfy.sh kombinieren. Die Nutzung von ntfy.sh ist kostenlos, man kann aber auch den ntfy-Server selbst hosten. Einmal in Pinchflat eingerichtet, sieht das dann z.B. so aus:

Um auf dem Laufenden zu bleiben, muss man nicht mehr zur Datenschleuder Youtube/Google gehen und die “Glocke abonnieren”.

Das letzte Recap ist zwar schon zwei Jahre her, aber ich wollte sowieso ein paar Sätze zu einigen Titeln schreiben, die ich dieses Jahr konsumiert habe. Interessanterweise gibt es seit dem letzten Mal LLM (Large Language Models), die diese Texte auch für mich hätten vorschreiben können. Ich habe mich jedoch dagegen entschieden. Dieses Jahr habe ich einige physische Bücher gelesen, vor allem fiktionale Romane und Sachbücher. Ich hoffe, dass ich in der Lage sein werde, das Interesse einiger Leser für diese Titel zu wecken.

2021 war ein langes Jahr und dieses Jahr konnte ich sogar meine Liebe zu Mangas erneuern und ein wenig meinen “Pile of Shame” abarbeiten. Mit diesem Blog Beitrag möchte ich mal kurze Reviews geben zu den Serien, Mangas, Filme und Spiele, die ich persönlich dieses Jahr genossen habe. Eine Vorwarnung gebe ich jedoch das ich ein wenig spoilern könnte, sofern ich denke das man durch diese Information den Titel schmackhafter machen kann für Unentschlossene. Ich verzichte außerdem auf 10er Bewertungen, da jede Person einen anderen subjektiven Eindruck hat.

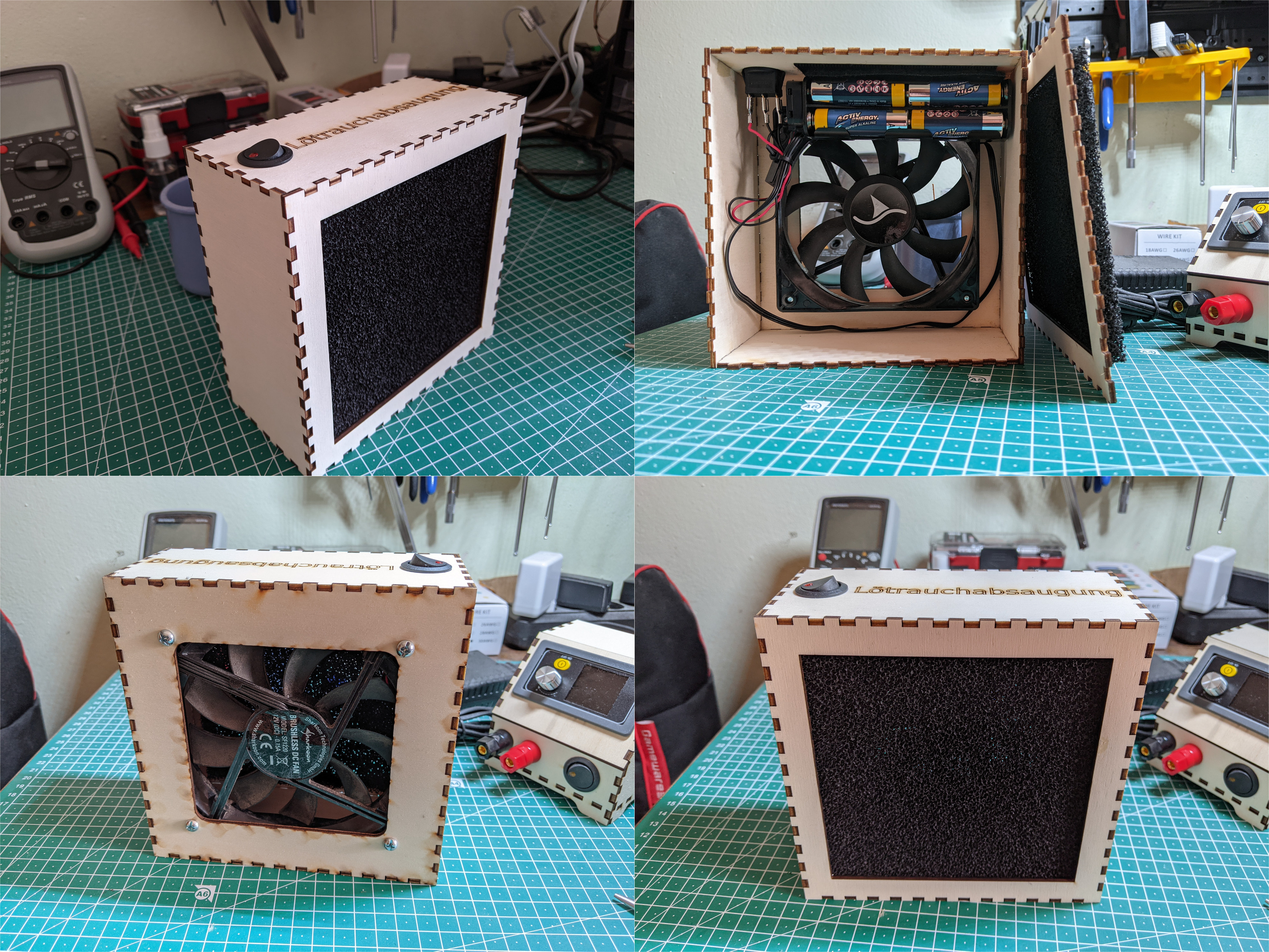

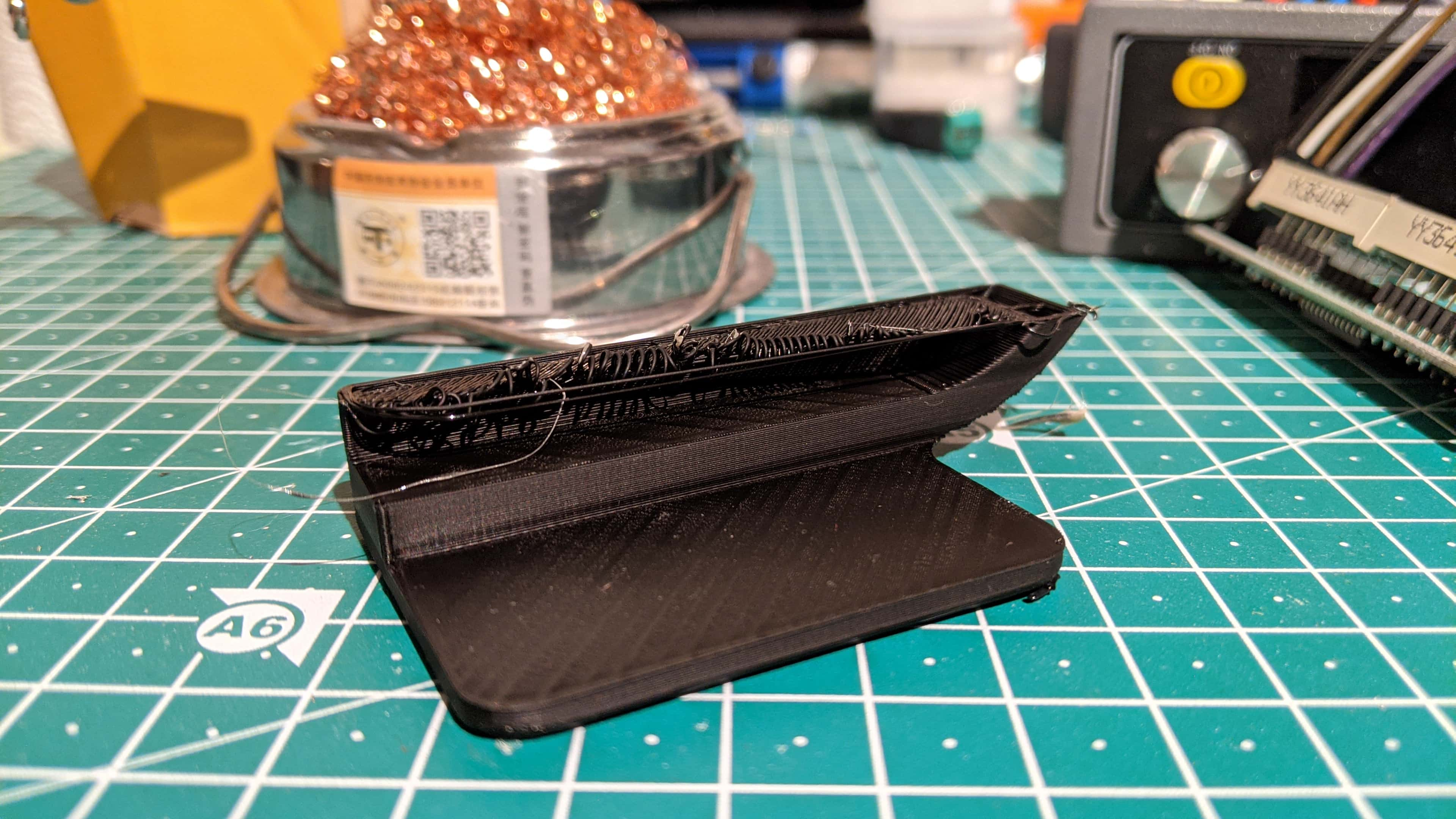

In einem letzten Blog Eintrag hatte ich bereits meine Anfänge mit einem Lasercutter erzählt. Dies Mal habe ich etwas Nützlicheres damit gebastelt und was ich eigentlich schon lange anschaffen hätte sollen: Eine Lötrauchabsaugung

Obwohl ich bleifreies Lot verwende, so ist auch dieses nicht komplett unbedenklich und auch deren Dämpfe sollte man in einem geschlossenen Raum nicht zu viel einatmen. Mit dem kommenden Winter wird es schwerer mal eben durchzulüften während man lötet und fertige Lösungen zur Absaugung fangen bei mindestens 30 € an und werden schnell teuer. Da ich noch einen alten Computerlüfter herumliegen hatte und noch andere Kleinigkeiten habe ich einfach mir selber was gebastelt. Die Einkaufsliste ist dabei relativ kurz ausgefallen:

Das meiste hatte ich bei meinem letzten Einkauf aus China von AliExpress noch in Fülle da, sodass der endgültige Preis für mich selber noch mal deutlich nach unten ging.

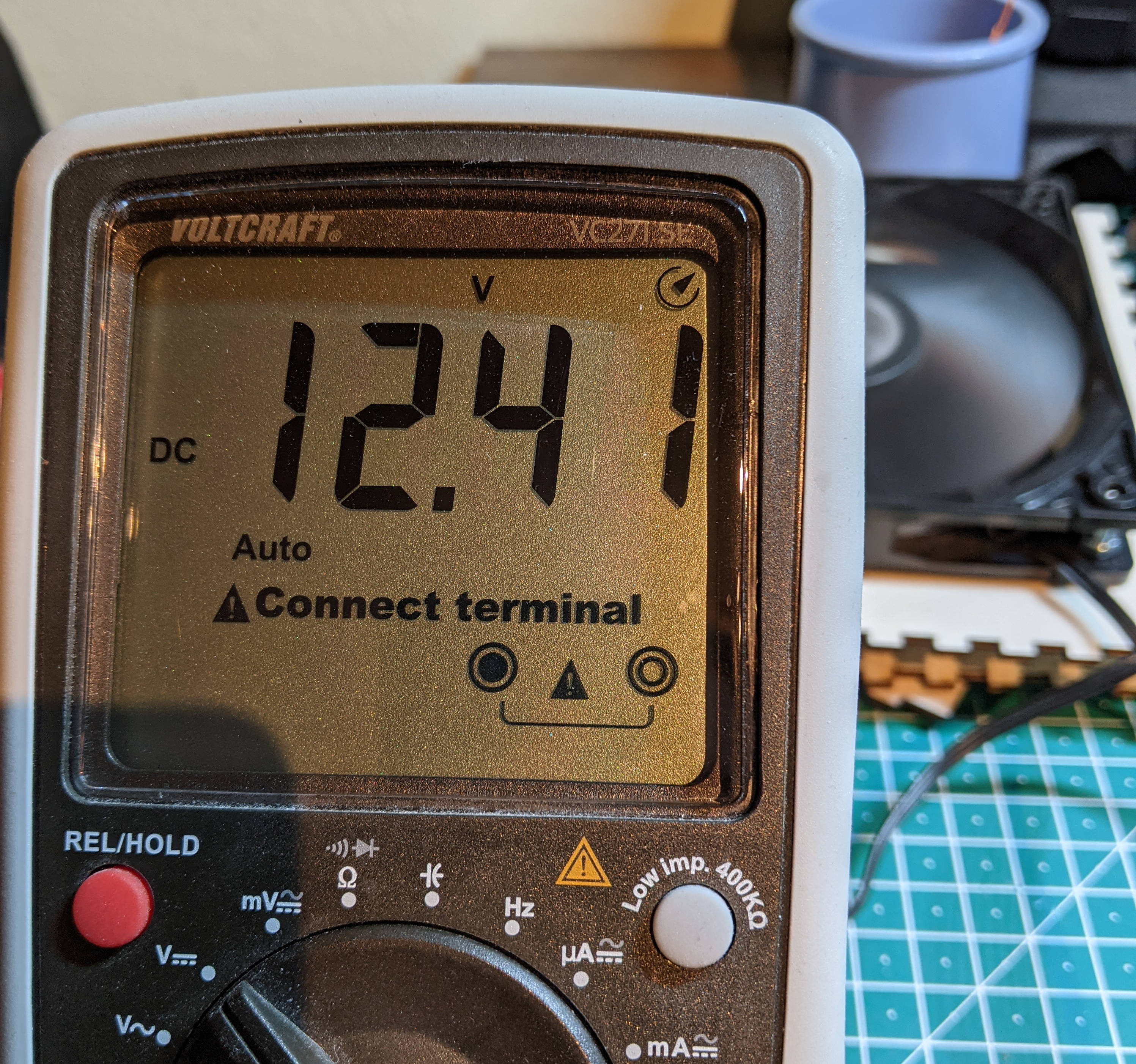

Ich habe mich bei der Stromversorgung für 8 x AA 1,5V Batterien entschieden da diese günstig zu bekommen sind, das Projekt mobil zum Mitnehmen machen und weil einfach noch genug davon herumliegen hatte. Der Batteriehalter ist mithilfe von Klettband innen befestigt um diesen rauszunehmen und mit neuen Batterien aufzufüllen. Mit meinem Multimeter habe ich eine Spannung von 12,41 V gemessen. Einen Nachteil gibt es hier natürlich: Und zwar sinkt die Spannung von AA-Batterien gegen Ende ihrer Laufzeit und der Lüfter wird langsamer drehen. Genaue Laufzeiten habe ich auch noch aufstellen können und muss diese noch selber austesten in den kommenden Wochen.

Der Aktivkohlefilter ist mithilfe von Sekundenkleber angeklebt und hält überraschend stabil. Bis ich die richtigen Abmessungen für die Löcher vom Lüfter hatte, hab ich drei Versuche benötigt. Der Wippschalter hält ohne Kleber im ausgelaserten Loch. Das Grundgerüst zum lasern habe ich mithilfe von Boxes.py generiert und dann mithilfe von Inkscape erweitert um Löcher für Wippschalter, Filter und Lüfter passend herauszuschneiden.

In ersten Tests mit einer Kerze habe ich festgestellt das der Lüfter fast zu gut läuft und im Video unten fast die Flamme der Kerze komplett eingezogen hat. Man könnte natürlich noch eine Form eines Voltage Regulators einbauen, um etwa stabile 12 V zu liefern oder auf weniger zu gehen damit der Lüfter langsamer läuft.

Zuerst hatte ich die Idee als “Serviceklappe” das obere Holzstück mit dem Aufdruck und Wippschalter zu nutzen. Nach ersten Tests habe ich jedoch festgestellt das auch die vordere Platte mit dem Filter möglich ist, wenn man alle anderen Platten etwas schief verklebt. Einmal eingesetzt muss man erst mit einem spitzen Gegenstand die Platte rausfrimmeln und hält gut. Das hat den Vorteil das man eines Tages den Filter relativ einfach tauschen kann.

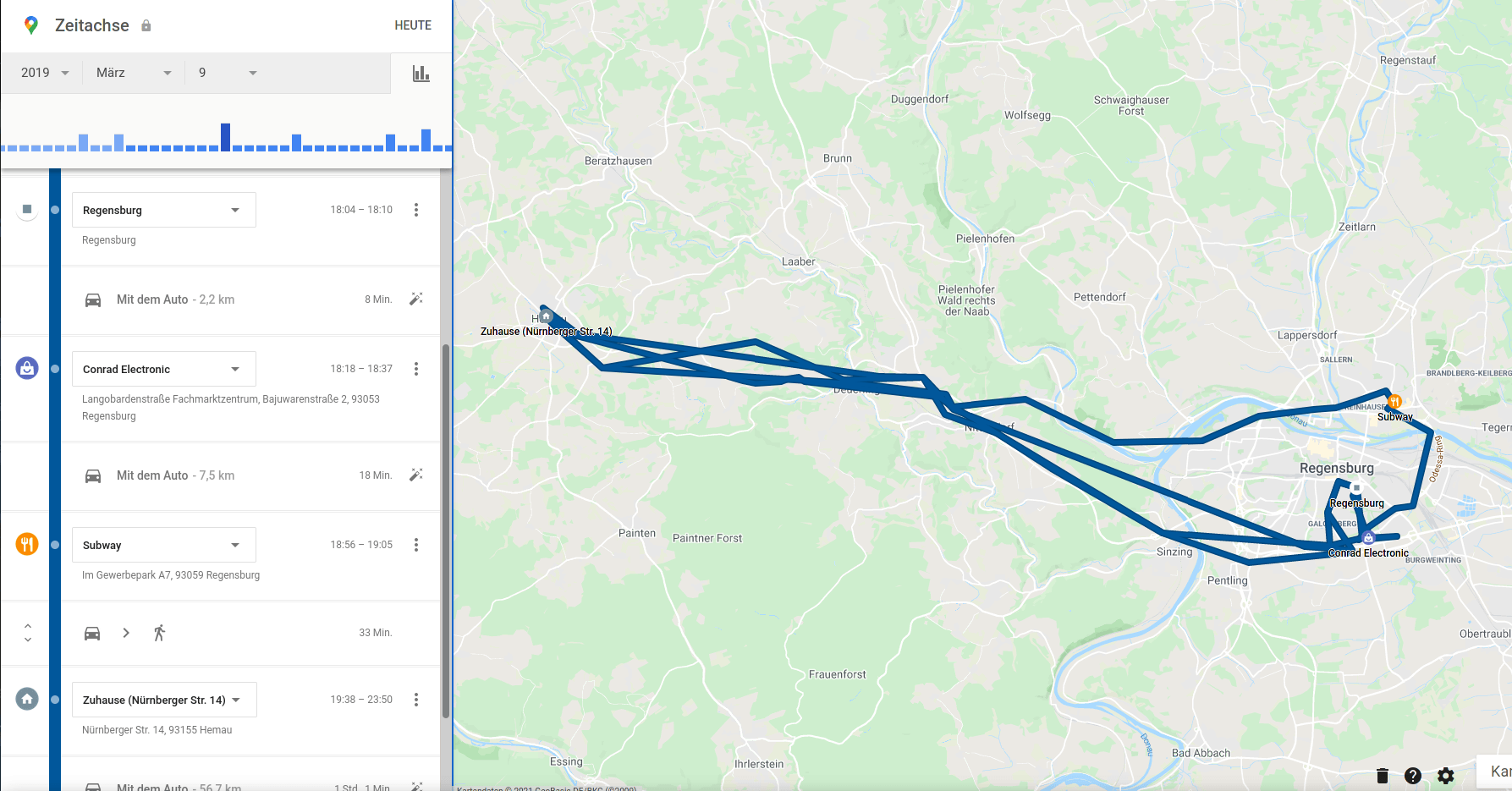

Vor über zwei Jahren bin ich von meinem alten iPhone auf mein immer noch aktuelles Google Pixel Handy umgestiegen. Das hat ehrlicherweise einen weiteren Umstieg nach hinten verschoben, den ich schon seit sehr langer Zeit plane: Endlich Tschüss zu Google zu sagen und wieder einen großen Teil meiner Privatsphäre zurückerlangen. Es gibt sogar einen eigenen Wikipedia Artikel nur um Kritikpunkte über Google bzw. deren übergeordneten Konzern Alphabet aufzulisten: Kritik an der Google LLC. Wer immer noch nicht versteht, warum ich weg von Google möchte, kann gerne mal durch Google Takeout bzw. Google Maps Zeitachse durchgehen und sich selber ein Bild darüber machen, was Google eigentlich über mich weiß. Gründe gegen Google gibt es also genug, aber leider gibt es auch viele Gründe warum ich mit Google fest verkettet war oder teilweise immer noch bin.

Vor 2017 hat Google bei seinem Mail Dienst Gmail auch noch völlig unverblümt alle E-Mails automatisch analysieren lassen, inzwischen ist Google da ein wenig zurückgerudert nimmt sich aber immer noch weitreichende Rechte zum Lesen einiger Daten aus dem Gmail Postfach heraus um Features wie “Smart Reply” effizienter zu nutzen oder erlaubt Gmail Add-ons weiterhin Zugang.

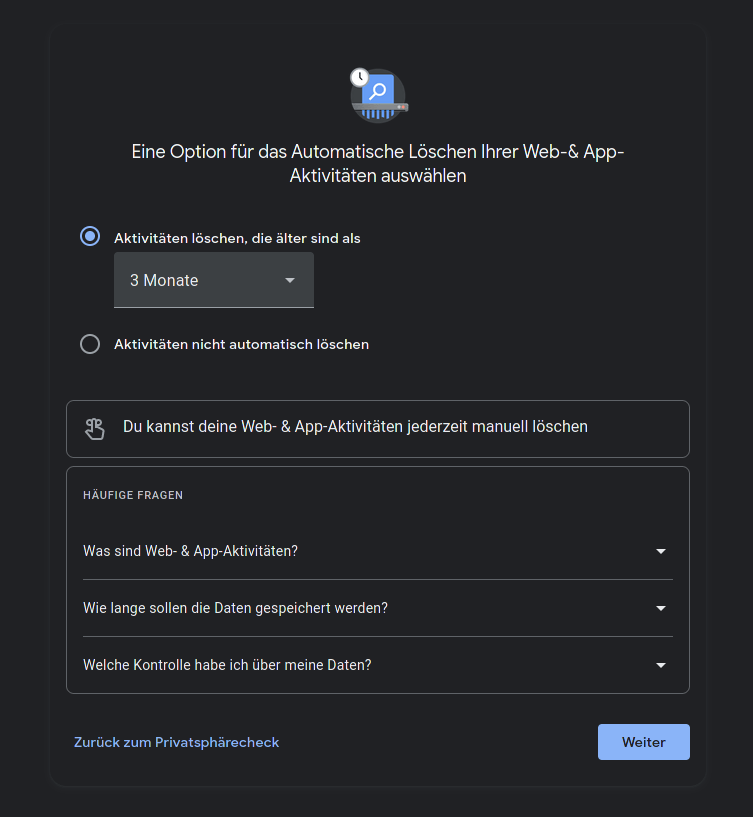

Ein Blick, in den Google Privatsphärecheck lohnt, sich da Google inzwischen ein wenig dem Datenschutz entgegenkommt, wenn man es sich so einstellt, von Haus aus darf man aber keine Wunder erwarten.

Android

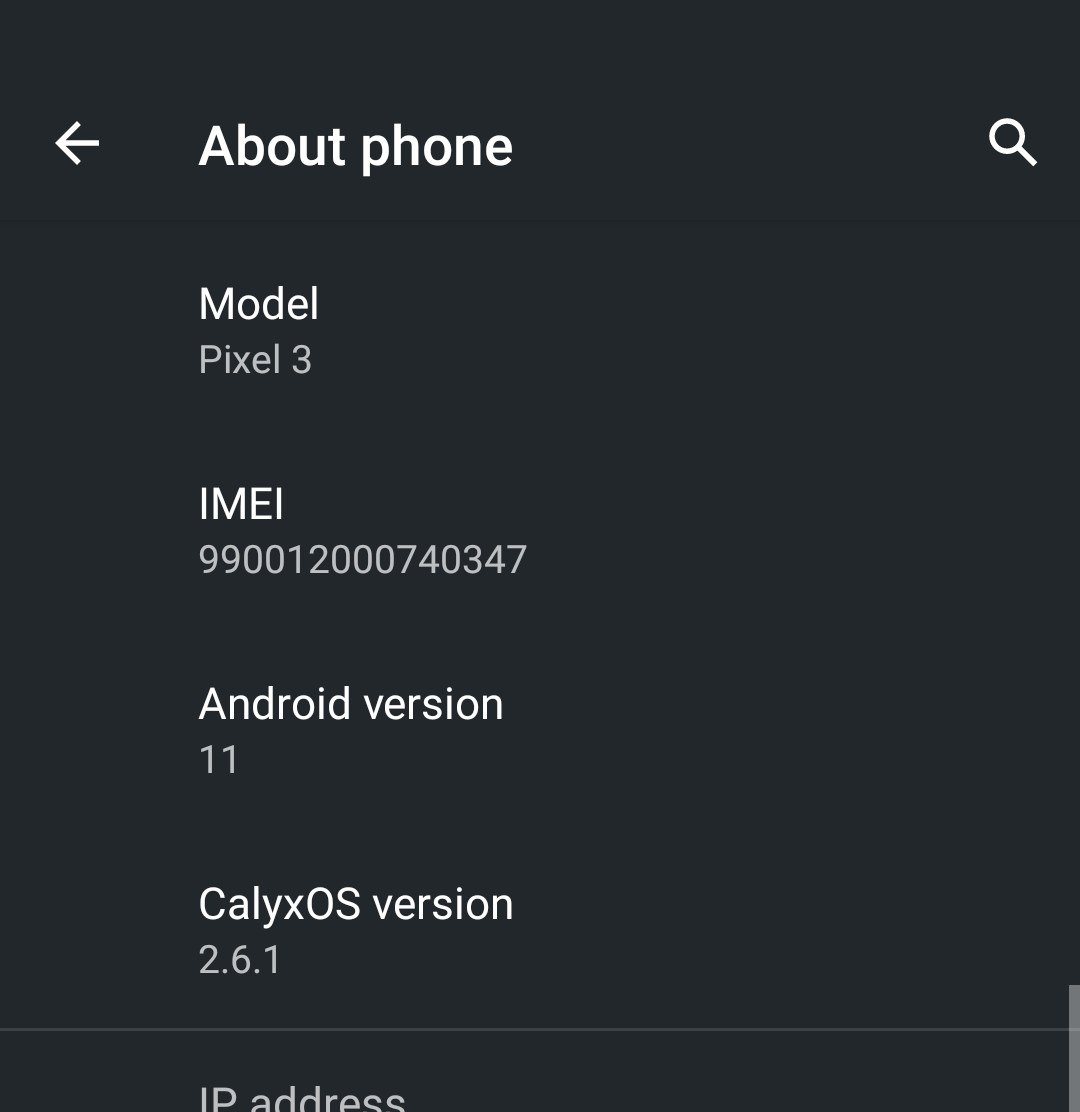

Einer der größten Elefanten im Raum ist hier klar, dass ich Android nutze auf einem Gerät von Google selbst. Glücklicherweise stellt sich der letzte Punkt als die Rettung heraus den neue Custom Android Roms wie CalyxOS oder GrapheneOS laufen nahezu ausschließlich auf Google Pixel Geräten mit dem einfachen Grund, das man hier den Bootloader wieder sperren kann trotz eigener Keys, damit wird die Custom Rom wieder genauso sicher gegenüber physischen Angriffen wie das vorinstallierte Android. Außerdem liefert Google für seine eigenen Geräte pünktlich monatlich (Sicherheits-)Updates und beide CalyxOS und GrapheneOS können deswegen mit neuestem Android 11 punkten.

CalyxOS im Speziellen hat es mir angetan, leider ist mir GrapheneOS zu restriktiv und beschneidet brutal die Nutzungsmöglichkeiten des Handys durch den Versuch so Datenschutzfreundlich wie maximal möglich zu werden. Bei der Installation von CalyxOS wird man stattdessen gefragt, ob man MicroG vorinstallieren möchte oder nicht. MicroG als Alternative zu Google Play Services versucht viele der API Schnittstellen so Datenschutzfreundlich wie möglich bereitzustellen aber kann, das nicht immer bewerkstelligen, weswegen es von GrapheneOS nicht unterstützt wird. Zusätzlich fragt CalyxOS ob man den Aurora Store installieren möchte, eine open source App um Apps aus dem Google Play Store herunterzuladen ohne Google Play Dienste. Weitere Alternativen wären /e/OS oder LineageOS. Jedoch unterstützt /e/ noch nicht mein Pixel 3 und LineageOS hängt oft sehr stark hinter Android Feature Updates hinterher, Beispielweise kam LineageOS 18.1 basierend auf Android 11 erst im April 2021 heraus.

CalyxOS AOSP vs. Pixel Android

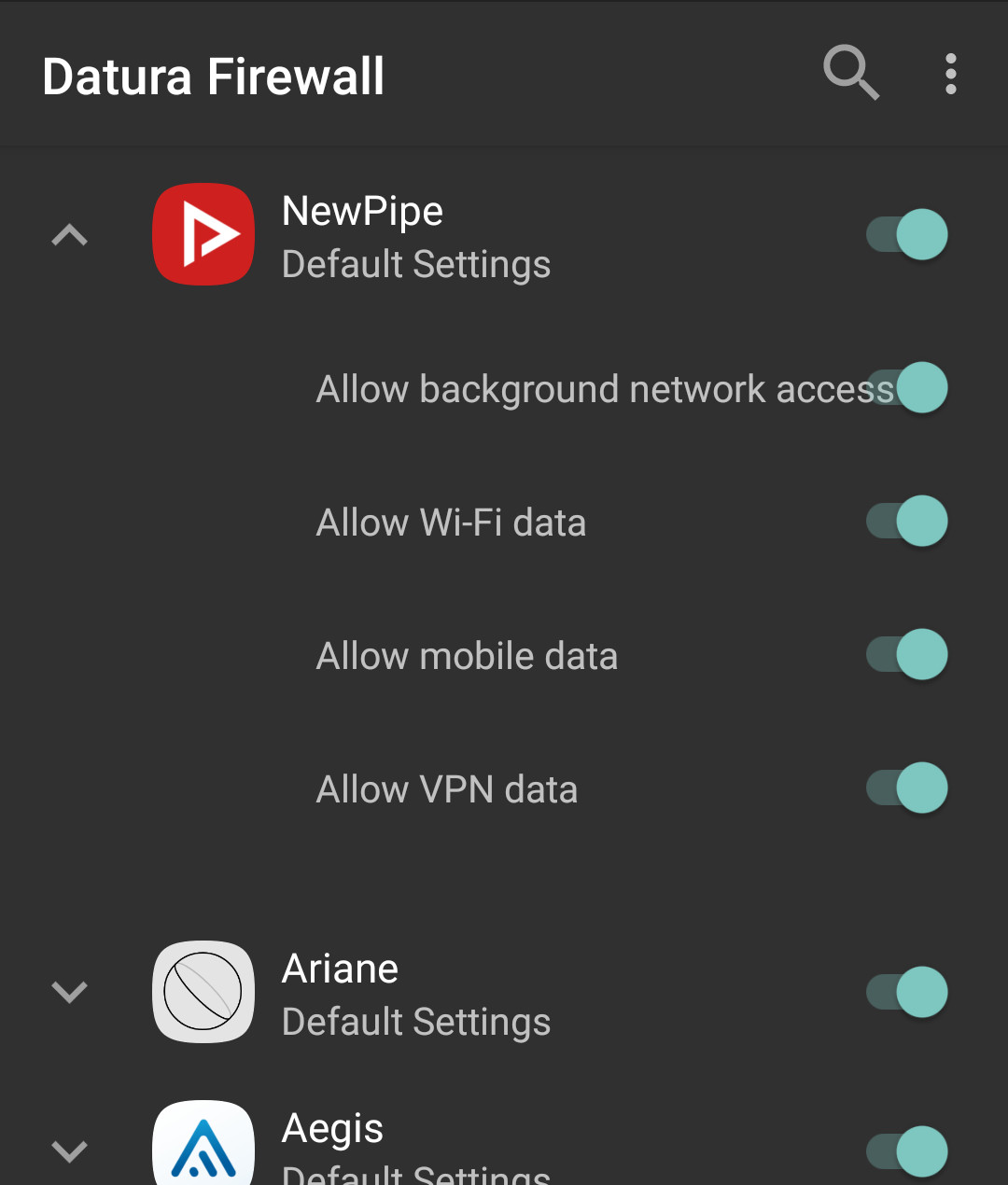

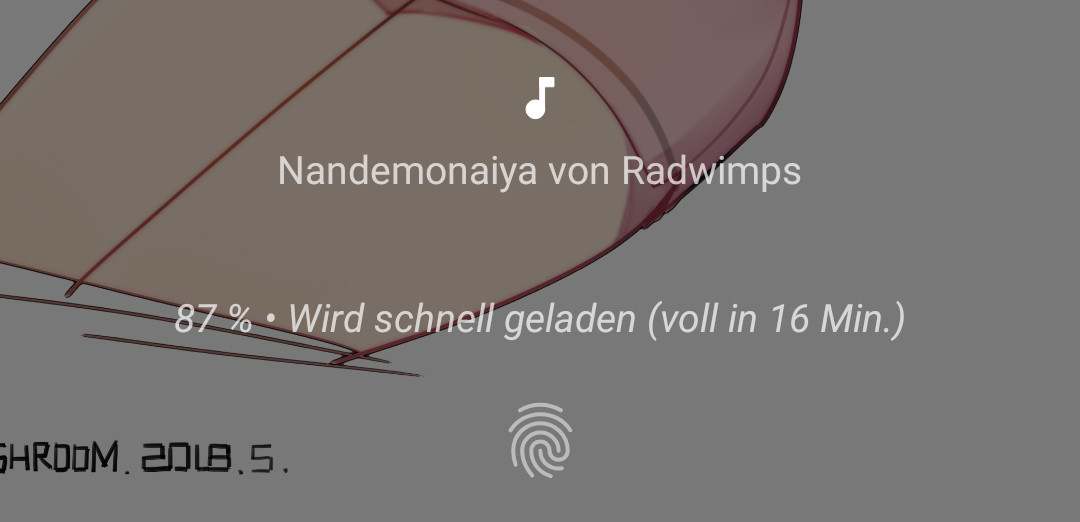

In meinem alten Blog Eintrag zum Umstieg auf Google Pixel hatte ich schon angemerkt das Google hier sich das Recht rausnimmt exklusive Pixel Features zu Android hinzuzufügen welche oft erst Monate/Jahre später in die Open Source Variante von Android “AOSP” einfliesen (wenn überhaupt). Durch den Umstieg auf eine Custom Android Rom wie CalyxOS verliert man hier diese Features, das ist aber nur halb so schlimm, weil die Entwickler einige Features selber hinzugefügt haben bzw. von LineageOS übernahmen haben die man bei Google wohl nie bekommen würde. Besonders erfreut bin ich über die Option einen Screensaver einzustellen während das Handy auflädt oder gedockt ist, ein Feature was komischerweise immer noch Google Pixel Stand exklusiv ist (welcher 79 € kostet). Außerdem findet man seit einigen Monaten eine Systemfirewall App vor, um ganz einfach Apps den Netzwerkverkehr zu entziehen. Anders als “Stock” Android gibt es auch eine nützliche Musik App standardmäßig während man bei Android lange Zeit nur die eher spärliche Google Music App bekam welche neuerdings von Youtube Music ersetzt wird.

Das nächste coole Feature ist das man sich automatisch Updates vom F-Droid Store herunterladen und installieren lassen kann, bei normalem Android ist, das nicht möglich da F-Droid keine Systemapp ist und Google behält sich dieses Privileg seinem Google Play Store vor. Ähnlich geht es zukünftig auch mit dem Aurora Store, diesem fehlt die Möglichkeit schlicht seit dem letzten großen Update. Das einzige, was wirklich fehlt, sind In-App Käufe aus dem Google Play Store, man kann sich im Aurora Store mit seinem Google Account anmelden und gekaufte Apps zu installieren aber In-App Käufe können nicht abgerufen werden. Das ist besonders traurig bei der App vom deutschen Wetterdienst, diese entfaltet erst nach einem In-App-Kauf sein volles Potenzial.

Alternative Apps

Seit ich den F-Droid Store entdeckt habe versuche ich möglichst viele Apps von dort zu beziehen. F-Droid erlaubt ausschließlich open source Apps und das F-Droid Team kompiliert diese selber, außerdem sind Tracker und Werbung explizit verboten. Einige Alternativen möchte ich hier auflisten, welche ich selber nutze:

Trotz dieser nicht kleinen Liste, gibt es viele Apps trotzdem nicht im F-Droid Store. Komischerweise sind darunter auch Firefox und Signal, als Firefox Ersatz gibt es aber Fennec und CalyxOS liefert Signal als System App aus für SMS. Für Signal gibt es auch den Fork Molly mit eigenem F-Droid repository. Ansonsten sollte der Aurora Store den Rest abdecken, jedoch geht eine App hier komplett unter: Die Pixel Camera App oder oft GCam genannt Eines der großen Verkaufsargumente für das Google Pixel, ist deren Kamera App welche aus dem kleinen Kamerasensor unglaubliche Bilder zaubern kann. Diese findet sich jedoch weder im AOSP noch im Play Store / Aurora Store zum Laden. Meine momentane Lösung ist sich von APKMirror die “GCam - BSG’s Google Camera port” App zu laden. Das ist nicht die schönste Möglichkeit an die App zu kommen aber verzichten möchte ich auf die App auch nicht.

Eine andere App wofür ich noch keinen guten Ersatz gefunden ist meine Musik App, genauer genommen BlackPlayer EX den ich immerhin per gekaufter Zusatz-App freischalten konnte, anstelle von In-App Käufen.

YouTube

Der zweite große Elefant im Raum ist wohl klar YouTube, mit seiner gigantischen Monopolstellung kommt man kaum drum herum. PeerTube versucht das Problem durch ein dezentralisiertes Peer-to-Peer-Netzwerk abzulösen, leider ist dieses jedoch oft sehr langsam und man findet vor allem Content hier, welcher schlicht überall anderswo gelöscht werden würde, weil es gegen die AGB verstoßen würde. Während ich PeerTube von der Seite im Blick behalte habe ich stattdessen einen genaueren Blick auf Invidious geworfen und hoste eine eigene Instanz davon auf meinem Server für privaten Gebrauch.

Invidious ist ein alternatives Frontend für YouTube und kann auch meine Watch History speichern sowie Playlisten. Ähnlich verhält es sich mit NewPipe als App für Handy und bietet ähnliche Funktionalitäten an ohne direkt Google alles zu erzählen. Invidious und NewPipe unterstützen beide auch SponsorBlock wodurch viele Youtube Videos gleich viel angenehmer zum Anschauen werden, leider gibt es momentan noch keine Möglichkeiten meine Playlisten und Watch History zwischen beiden zu teilen.

Ich nutze Invidious erst seit kurzem und habe ich schon einige Kleinigkeiten gefunden die nerven oder fehlen, ich werde es weiter testen, weil es bislang die beste Alternative für mich darstellt.

Gmail

Gmail war der Grund warum ich überhaupt einen Google Account erstellt hatte, der Umstieg hier ist für mich auch noch lange nicht vorbei und wird das wahrscheinlich nie richtig werden. Als Ersatz für Gmail nutze ich hauptsächlich momentan die Groupware Lösung von meinem VPS Anbieter Netcup, das kostet zwar wenige Euro im Monat aber dafür kann ich E-Mail-Adressen mit meiner Domain nutzen. Groupware bietet außerdem einen Kalender und ein Kontaktbuch das sich über CalDAV und CardDAV über DAVx⁵ aufs Handy synchronisieren lassen. Der einzige Wermutstropfen hier ist das Netcup keine Catch-All/Wildcard E-Mail-Adressen anbietet. Eine andere beliebte Alternative wäre ProtonMail, evtl. schaue ich mir das auch noch eines Tages genauer an.

Vor einigen Jahren hatte ich noch selbst gehostetes Mailcow genutzt aber meine E-Mails wurden ständig bei verschiedenen Anbietern als Spam markiert, obwohl ich alle Einstellungen vorgenommen habe für maximale Sicherheit aber das schien mir ein Kampf gegen Windmühlen.

Trotz allem behalte ich jedoch meinen Google Account für Gmail, weil ich mich über die vielen Jahren bei hundert verschiedenen Diensten mit meiner Gmail Adressen angemeldet habe und es extrem lange dauert nach und nach alle umzustellen.

Webbrowser

Glücklicherweise bin ich seit vielen Jahren Nutzer von Firefox und musste ich mich hier nicht von Google Chrome trennen was warum auch immer der absolut beliebteste Webbrowser weltweit geworden ist. Vor allem nach den letzten Bestrebungen von Google Werbeblocker Add-ons zu beschneiden oder ihren Vorstoß Cookies durch ihr eigenes Fingerprinting (FLoC) zu ersetzen hoffe ich das Google Chrome endlich mal ein wenig Marktanteile verliert.

Leider funktionieren einige Websites (namentlich auch viele Google eigene Webseiten) gar nicht oder nur sehr schlecht mit Browsern die nicht auf Chromium basieren. Dafür nutze ich ungoogled-chromium als Zweit-Browser, weil Chromium selber, obwohl es Open Source ist, trotzdem gerne mit Google Servern sich mitteilt.

Auf dem Handy nutze ich statt Firefox jedoch den Firefox-Fork Fennec, weil Firefox selber nicht bei F-Droid erhältlich ist.

Leider muss ich jedoch auch sagen, dass Firefox in seiner Standardausstattung nicht dem entspricht, was ich mir vorstelle, von einem perfekten Webbrowser. So rüste ich für Firefox normalerweise uBlock Origin nach und nehme einige Privatsphäre-Einstellungen vor. Dennoch bietet Firefox auch wirklich praktische Funktionen wie Firefox Multi-Account Containers bzw. Google Container.

Suchmaschine

Google begann als Internet Suchmaschine und ist immer noch Marktführer hier bei weitem und ich muss gestehen das Google durch die vielen Daten über einen auch wirklich passende Suchergebnisse liefert. Jede Suchmaschine, die Wert auf Privatsphäre legt, wird deshalb immer hinterherhinken. Trotzdem benutze ich seit vielen Jahren jedoch standardmäßig DuckDuckGo als Alternative. DuckDuckGo bekommt einen großen Teil seiner Suchergebnisse von Bing aber unterhält auch eigene Scraper. Besonders praktisch finde ich die sogenannten Bangs bei dennen z.B. “!aw” einen direkt zum Arch Linux Wiki führen oder “!stackoverflow” direkt zu StackOverflow, wer unzufrieden mit dem Suchergebnis ist, kann auch mit “!g” direkt bei Google suchen. Dennoch ist auch bei DuckDuckGo Zweifel angebracht da die Firma hinter der Suchmaschine “Duck Duck Go Inc” ihren Sitz in Amerika hat und damit dem CLOUD Act und PATRIOT Act bzw. Freedom Act unterliegen.

Alternativen zu DuckDuckGo aus europäischen Gefilden sind z.B. SearX und Qwant. SearX hat den interessanten Vorteil das man diese Meta-Suchmaschine selber betreiben kann während Qwant vor allem in Frankreich an Bekanntheit gewinnt. Leider konnte ich mich in beide noch nicht wirklich einarbeiten, vor allem SearX bei einigen öffentlichen Instanzen war für mich immer sehr langsam und brachte mich selten schnell zum Ziel als ich, das letzte Mal es genutzt hatte. Bis vor einigen Jahren war Startpage auch noch eine beliebte Methode um Google Suchanfragen hinter einem Proxy zu verschleiern, leider wurde der Dienst im Grunde 2019 von einer Werbefirma namens System1 aufgekauft und kann damit kaum weiterempfohlen werden.

Google Maps

Google Maps ist ein sehr mächtiges Werkzeug um Routen zu planen, den Weg von X zu finden, sich zu erkundigen, wann Restaurant Y geöffnet hat oder nachzuschauen, ob auf der Autobahn wieder Stau ist. Alternativen wie OpenStreetMap oder Apps wie OsmAnd~ wirken fast schon primitiv im direkten Vergleich. Wenig hilft es auch das OpenStreetMap und Google Maps Straßen teilweise anders benennt. Hin und wieder navigiere ich dann doch noch mal zu Google Maps über den mobilen Browser, immerhin trackt mich Google hier weniger krass als in der richtigen App.

Google Übersetzer

Google Übersetzer ist keine Frage ein mächtiges Werkzeug und die Kamera Funktion hat schon einige male mir aus der Patsche geholfen. Ich versuche so oft es geht Alternativen wie LibreTranslate, SimplyTranslate oder DeepL zu nutzen aber lande trotzdem immer mal wieder zurück bei Google Übersetzer.

Android Auto

Mein neuestes Auto hat Support für Android Auto und das habe ich auch eine Zeit lang genutzt. Android Auto ist jedoch extrem stark verzahnt mit Google Maps und sendet permanent Daten, wirklich innovative Funktionen wie eine Anzeige für die besten Ampelzeiten fehlen jedoch trotzdem. Es gibt momentan keine open source Alternative und in AOSP ist Android Auto auch nicht zu finden. Schade aber mein Auto hat von sich auch eine Navigationsfunktion und kann Musik per Bluetooth abspielen, wodurch das Anschließen an ein Ladekabel entfällt und mein Handy in der Hosentasche verbleiben kann.

Google Authenticator

Ich bin mir unsicher, ob Google das absichtlich gemacht hat oder es einfach nur Zufall ist das eine Zweit-Faktor-Authentisierung oft mit Google Authenticator wie ein Synonym verwendet wird. Fakt ist jedoch das TOTP/HOTP Token Generatoren nicht an Google gebunden sind und es eine Menge alternativer Apps gibt. Glücklicherweise habe ich mich da früh nach Alternativen um gesucht und hatte gute Erfahrungen mit Aegis Authenticator und davor andOTP gemacht. In Zukunft möchte ich auch dem integrierten OTP Token Generator in Bitwarden eine Chance geben.

Google Fonts

Wahrscheinlich eher weniger bekannt aber letztes Jahr im April habe ich Beispielweise in diesem Blog die Aufrufe für die Lato Schriftart auf einen lokalen Abruf geändert anstelle von googleapis. Lizenz-technisch war das kein Problem. Eine komplette Alternative wäre z.B. Font Library Falls ich in Zukunft noch mal auf der Suche nach einer passenden Schriftart bin.

Google DNS

Obwohl DNS Resolver ein eher technisches Thema sind, wissen heutzutage auch viele weniger technisch versierte Nutzer das 8.8.8.8 der DNS Resolver von Google ist. Google DNS hat den Vorteil das er jederzeit extrem schnell ist und im Sekundentakt die DNS Einträge aktualisiert, während man bei einigen DNS Resolvern von ISPs kann man gerne mehrere Stunden warten für eine Aktualisierung wartet und/oder Weiterleitungen auf Suchmaschinen bekommt bei unbekannten Webseiten. Der nächst größere DNS Service wäre von Cloudflare die sich aber auch in ihren AGB vorenthalten Daten bei der Nutzung zu erheben, um ihre CDN Caching Lösung weiter zu optimieren. Quad9 bekam erst vor kurzem einen Dämpfer von der deutschen Justiz als Sony gegen sie geklagt hatte an einem deutschen Gericht. Ein weiterer beliebter Service aus Deutschland wäre noch LibreDNS. In der Vergangenheit hatte ich meinen eigenen DNS Resolver aufgesetzt auf Basis von Adguard Home oder Pi-Hole.

Google Analytics

Wer Webseiten betreibt, möchte oft wissen wie viele Nutzer und wie die Nutzer ihre Seiten nutzen. Matomo (ehemals Piwik) hatte mir da in der Vergangenheit oft gute Dienste geleistet. Lange Zeit hatte ich aber kein Tracking mehr genutzt bis ich vor kurzem über umami gestolpert was anonymes Tracking erlaubt ohne Cookies (und damit DSGVO-konform ohne Banner) mit weniger Ressourcen als Matomo und dabei auch noch gut aussieht. Dieser Blog benutzt seit kurzem übrigens auch umami!

Google Photos

Anscheinend für sehr viele Menschen sind der unlimited Storage von Bildern zu Google Photos für Google Pixel Geräte der ausschlaggebende Grund es zu kaufen. Ich habe sogar von einigen gelesen die sich extra ein Google Pixel der ersten Generation gekauft haben mehrere Jahre später, weil es den Bilder-Upload in Original Qualität erlaubt statt “nur” Hoher Qualitätsstufe und das Ausnutzen um Bilder von ihrer Vollformat Kamera auf das Pixel übertragen und dann in die Google Cloud. Ich habe das selber nie verstanden und dort nahezu nie etwas hochladen lassen.

Ich habe aber kurz nach Alternativen gesucht wie z.B. PiGallery2, Photonix oder Piwigo aber brauche dann für den Moment dann doch keines davon.

Google Drive/Docs

Ich brauche zum Glück nur sehr selten und wenig Speicher für Google Drive und ich habe das Glück das mein lokaler Hackspace für ihre Mitglieder eine Nextcloud Instanz mit 1 GB Speicher bereitstellt für jedes Mitglied. Dort kann ich zum Beispiel PDF Dateien hochladen und sie einfach mit anderen Leuten teilen, was meine Hauptnutzung von Google Drive war.

Google Hangouts / Google+ / Ingress

Vor einigen Jahren als ich noch Ingress gespielt habe, war Google Hangout und Google+ noch sehr beliebt in meiner Gruppe da Ingress bzw. Niantic damals noch offiziell zu Google gehörten. Das hat sich insofern gelöst als das Google Handgouts und Google+ von Google eingestellt wurden und ich inzwischen aufgehört habe Ingress zu spielen und Niantic sowieso nicht mehr zu Google gehört.

Google Keep

Für Notizen habe ich mir eine eigene Instanz von HedgeDoc (ehemals CodiMD) auf meinem Server installiert und nutze diese gelegentlich.

Google Music

Wie weiter oben bereits erwähnt hatte ich Google Music nie genutzt bevor es eingestellt wurde, nachdem ich aber Navidrome mal ausgetestet habe fand ich die Idee schon verlockend meine Musik zentral zu speichern und über verschiedene Clients auf dieselbe Bibliothek zugreifen zu können. Momentan nutze ich aber dann doch noch meine offline Musiksammlung, vielleicht wird daraus in Zukunft wieder etwas.

WearOS / Google Fit

Googles eigenes Betriebssystem für Smartwatches hatte ich bislang noch gar nicht auf den Schirm, weil ich einfach keine Smartwatch haben wollte. Es gibt jedoch mit AsteroidOS ein interessantes Projekt welches WearOS datenschutzfreundlich gestalten möchte ähnlich von Android Custom Roms. Leider unterstützt AsteroidOS nur sehr wenige und vor allem alte Smartwatches die kaum zu bekommen sind heutzutage. Ich habe mich momentan jedoch für eine günstige Fitness Tracker Armband entschieden, was ich mit Gadgetbridge nutzen kann und so datenschutzfreundlich hinbekomme. Ich hoffe einen eigenen Blog Artikel darüber in Zukunft schreiben zu können.

Blogger

Vergisst man gerne aber blogger.com gehört Google. Dieser Blog hier liegt jedoch nicht auf Google Servern, sondern bei GitHub Pages und wird per Jekyll generiert.

Google Pay

Meine Bank bietet eine eigene App an, über die ich per NFC bezahlen kann. Ehrlicherweise muss ich jedoch gestehen, dass ich deren Einsatz unter CalyxOS noch nicht ausgetestet habe, weil mir irgendwann das entsperren des Handys per Fingerabdruck beim Bezahlen teilweise echt nervig wurde und ich stattdessen plump per physischer Karte bezahle momentan.

Google Home / Google Assistant

Für die Heimautomatisierung erfreut sich Google Home bzw. Google Nest immer größerer Beliebtheit dank Google Assistant und sehr enger Verzahnung mit Android. Anstatt in der Cloud betreibe ich jedoch lieber meine Heimautomatisierung-Lösung Home Assistant selber und habe darüber in der Vergangenheit schon einen Blog Artikel geschrieben. Das einzige, was noch fehlt, ist eine wirklich nützliche Spracherkennung jedoch werden in dem Bereich alle möglichen Alternativen sehr schnell aufgekauft wie vor einigen Monaten erst Snips was vielversprechend aussah.

Google News

Hier bin ich altmodisch und pflege meine RSS Sammlung an Nachrichten mithilfe von FreshRSS und bin sehr zufrieden damit.

Fazit

Der Prozess sich komplett von Google zu trennen wird für mich wohl noch mehrere Jahre dauern und kann unmöglich über Nacht geschehen. Auch ist mir bewusst das viele Alternativen, die ich oben erwähnt, habe nur für meinen eigenen Anwendungszweck gut sein können während manch anderer dann doch eine Alternative bevorzugt oder trotzdem bei Google bleibt. Die Idee hinter dem “degooglen” sollte sein einen Fußabdruck an digitalen Daten, die man an Google aushändigt so klein wie irgend möglich zu halten, hier gilt auch der Grundsatz “Lieber spät als nie”.

Wer weitere Alternativen sucht wird eventuell bei degoogle.jmoore.dev, PrivacyTools.io oder Kuketz Blog wahrscheinlich fündig.

Letztes Jahr hatte ich in meinem Blog bereits über 10 Jahre Minecraft geschwärmt und heute ist auch schon Zeit für das nächste Jubiläum, das mir am Herzen liegt: Es geht um das Spiel Terraria

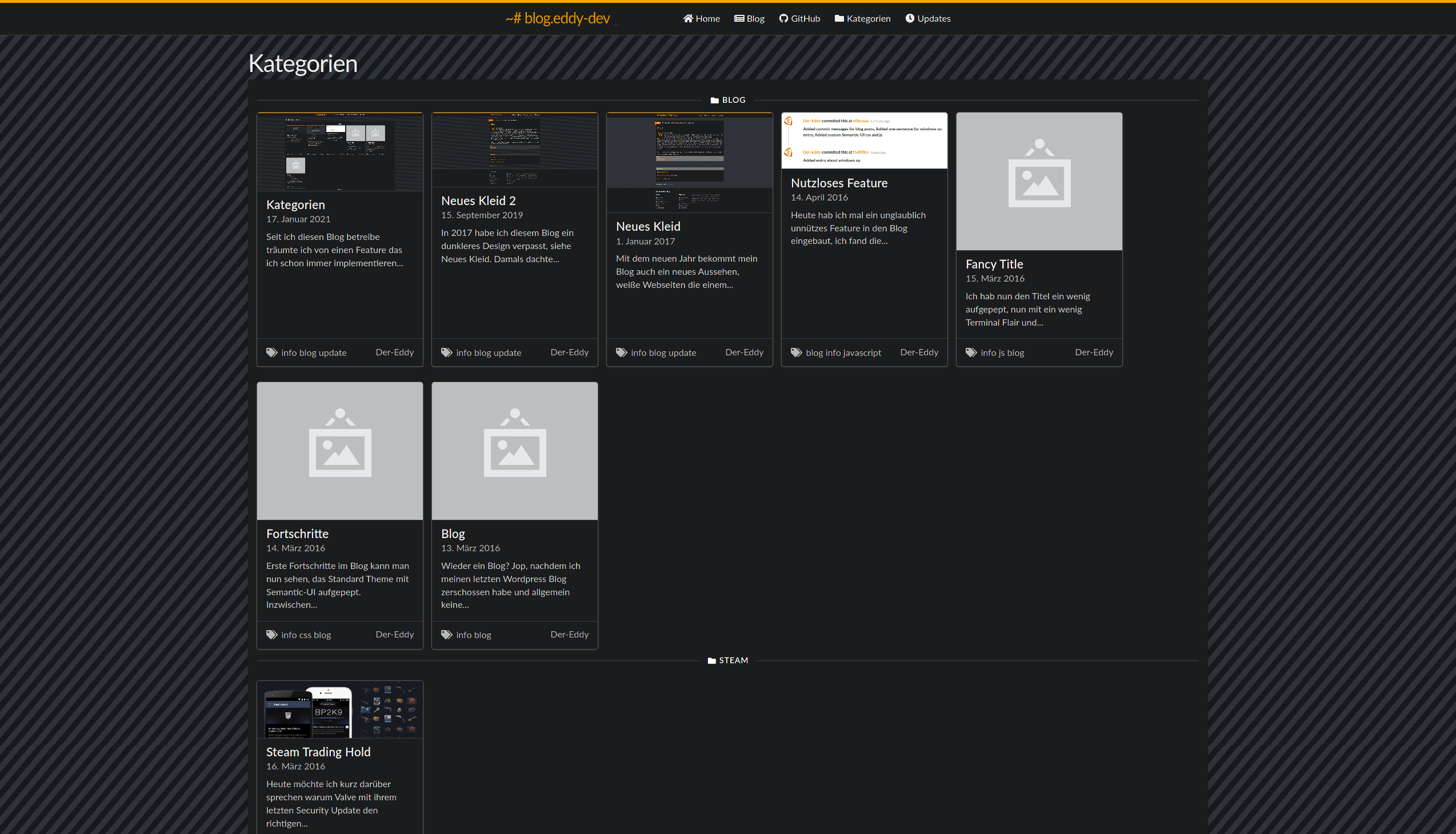

Seit ich diesen Blog betreibe, träumte ich von einem Feature, das ich schon immer implementieren wollte. Diese Woche hatte ich endlich die zündende Idee, wie so oft mehr spät als früh, um es endlich umzusetzen.

Und zwar geht es darum die Kategorien meiner Blog-Einträge endlich schön mit Bildern aufzureihen, zusätzlich kann man jetzt bei jedem Blog Eintrag oben links auf den Namen der Kategorie klicken und wird zur jeweiligen Übersicht weitergeleitet. Das sieht zwar nicht nach viel aus aber dafür musste ich einiges am Blog umschreiben damit es aussieht wie es jetzt der Fall ist. Für Blog Posts ohne Bild gibt es einen Platzhalter stattdessen.

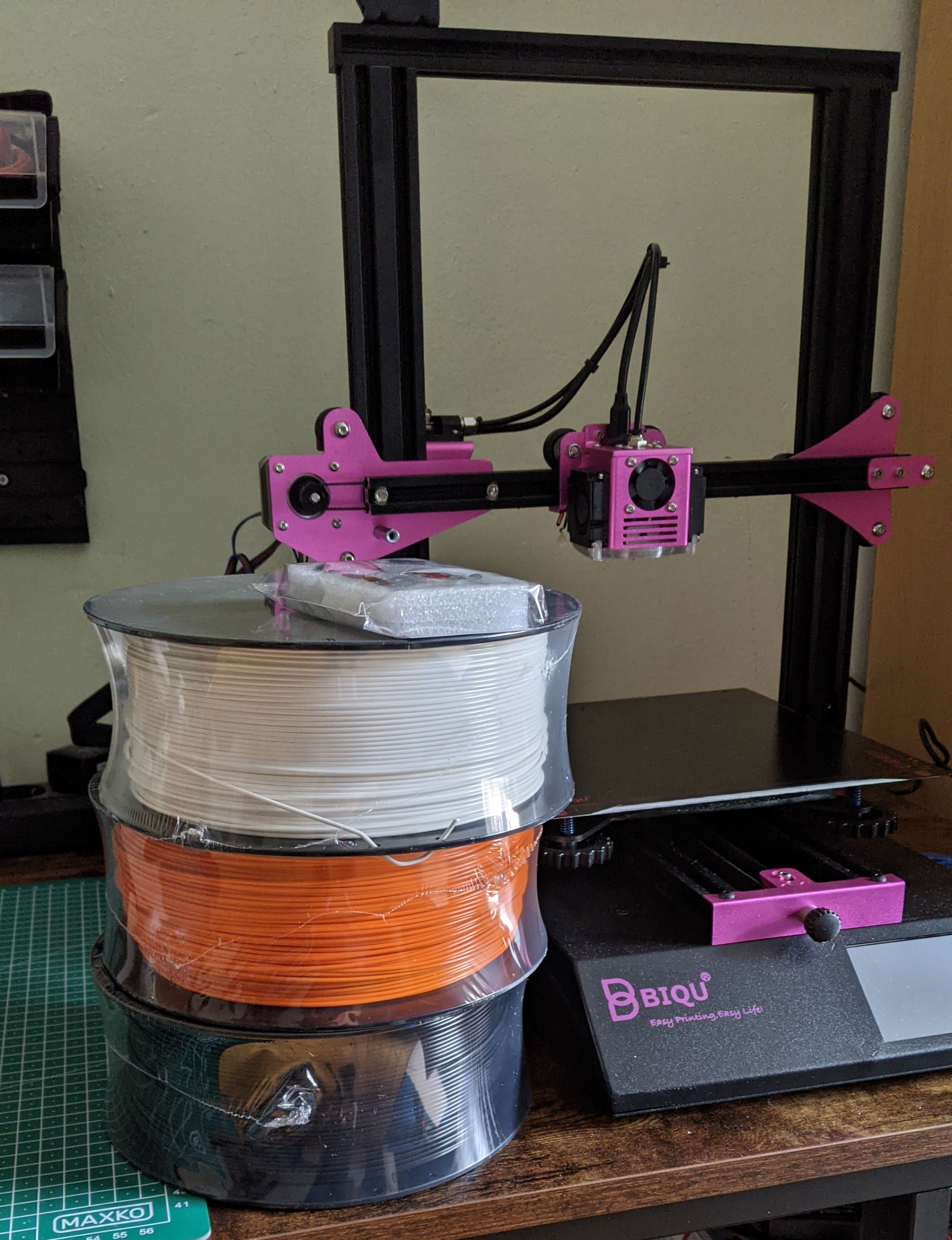

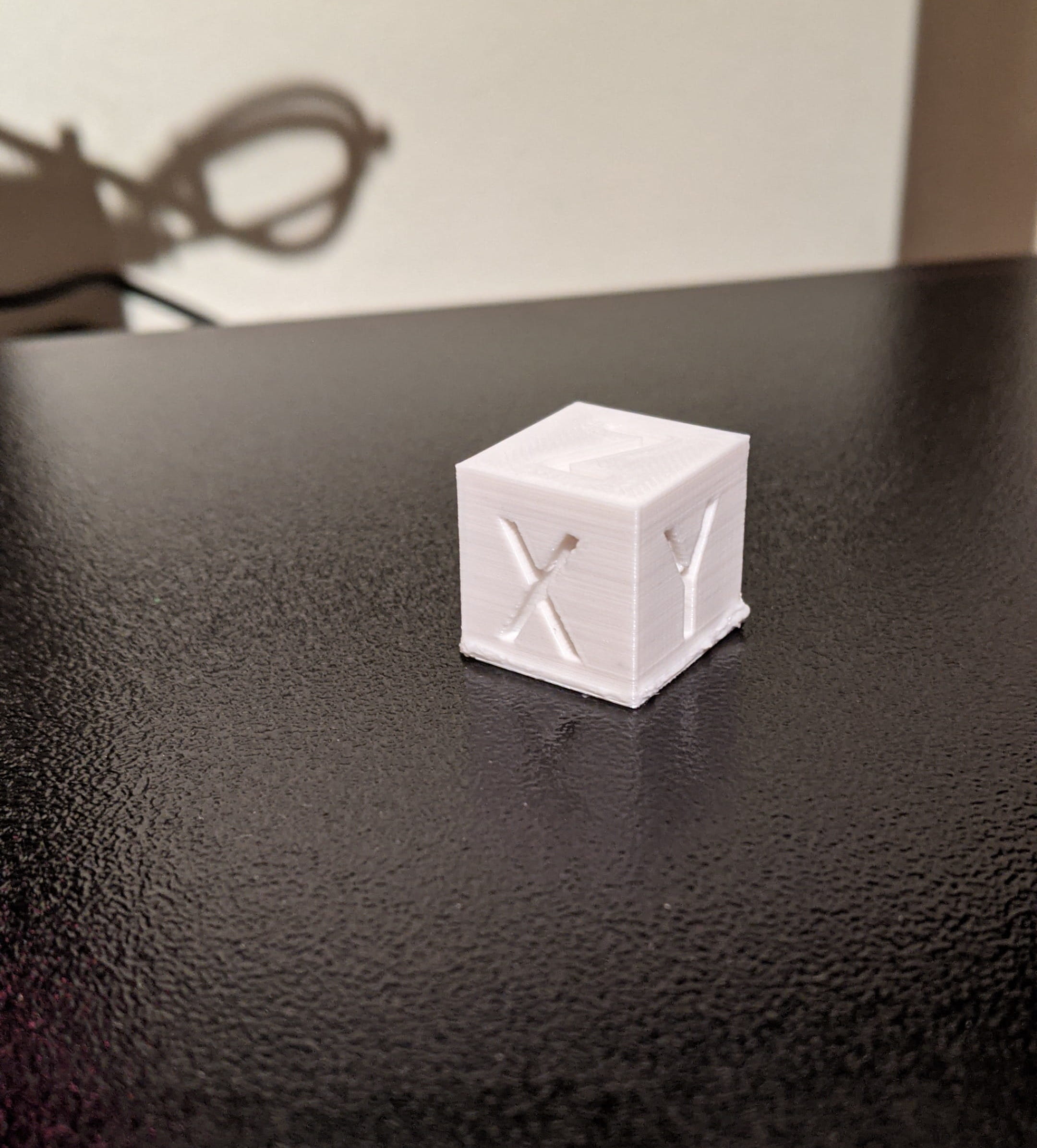

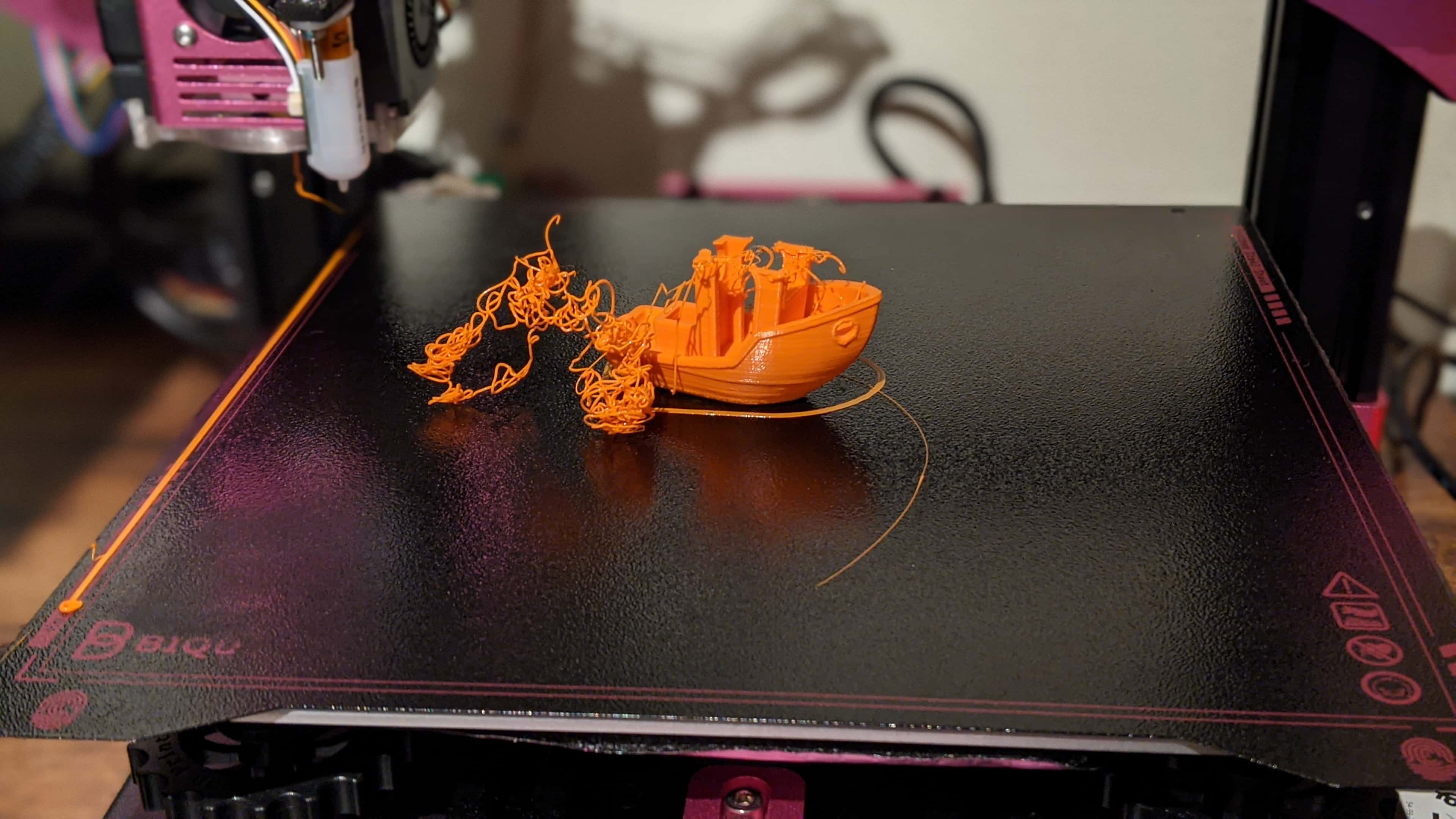

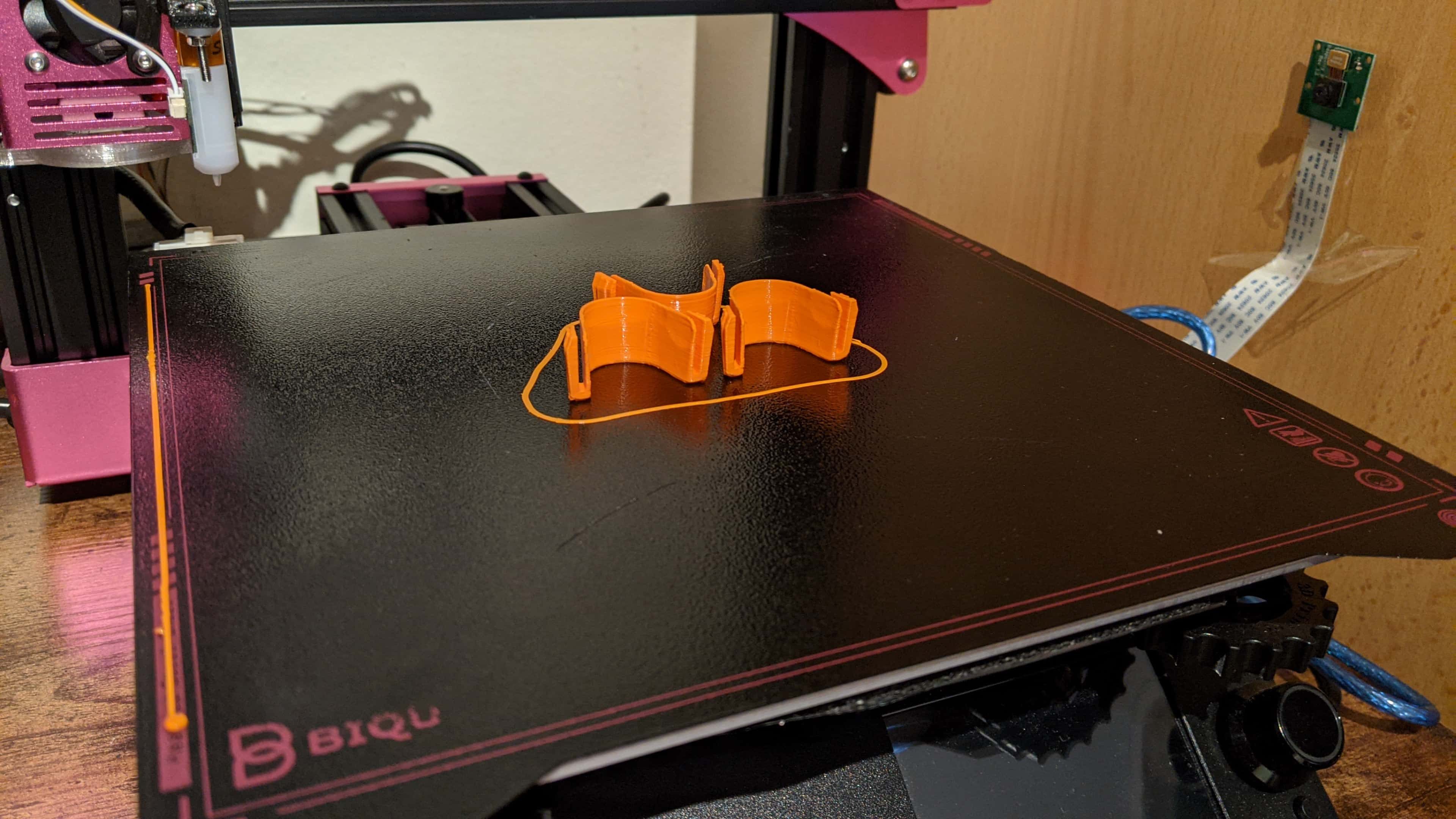

Im Oktober dieses Jahres hab ich ein neues Hobby angefangen, welches mir noch mal alle Nerven kosten sollte: Mein eigener 3D-Drucker

Zwar gibt es bereits einen eigenen 3D-Drucker (und ein weiteres Leihgerät) in meinem lokalen Hackspace, jedoch habe ich schnell festgestellt das ich nicht mehrere stundenlang einen 3D-Druck in den Hackspace Räumen beaufsichtigen kann im Moment. Die Auswahl war auch schwer genug, mit einem beschränkten Budget entschied ich mich für einen Drucker aus der unter 300€ Klasse, welche man selber zusammenbauen muss. Der Bekannteste in diesem Preisbereich ist wohl der Creality Ender 3 (Pro/v2). So schlau wie ich war hab ich mich jedoch gleich tiefer ins Getümmel gestürzt und habe mir mit fatalen Folgen den unbekannteren Ender Klon von BIGTREETECH (bekannt für zum Beispiel modifizierte Ender Mainboards) entschieden: der BIQU B1

Die Vorteile liegen klar auf der Hand: Großer mehrfarbiger Touchscreen + die Option auf den “alten” Monochromen Marlin Screen, am Gehäuse befinden sich Anschlüsse von BLTouch und LED-Stripes (beim Ender muss man beides nachrüsten), leise Stepper Motoren, eine magnetische Stahlplatte die man biegen kann als Druckbett anstatt ein Glasbett, LED Beleuchtung vom Hotend ohne Modifikation, bereits verstärkte Federn unter dem Druckbett und einige andere Kleinigkeiten die man sowieso wahrscheinlich als Upgrade eines Ender 3D-Druckers nachrüsten würde.

Der Touchscreen erwies sich als extrem hilfreich da man mithilfe diesem sogar custom Gcode Befehle eingeben konnte, wofür man normalerweise einen angeschlossenen Computer oder Octoprint benötigt. Vor allem, weil die Firmware mit der mein BIQU B1 ausgeliefert wurde einen Bug hatte, der die Z-Axis nicht bewegen ließ, ein M500 Reset und M502 Einstellungen speichern per Gcode Terminal brachte den Fix. Das größere Problem war das Finden von irgendwelchen Tipps online da jegliche 3D-Drucker von BIGTREETECH eher selten gekauft worden. Wer nicht schon sehr viel 3D-Drucker Wissen sich vorher angesammelt hat, wird hier oft vor Probleme stoßen für die man für andere 3D-Drucker schneller Lösungen findet. Besonders unpraktisch ist das sich BIGTREETECH sich bei der Nozzle vom Ultimaker inspirieren lassen hat, man kann anscheinend nicht einfach eine MK8 Nozzle wie für den Ender 3 nutzen, sondern muss auf nur extrem selten verkaufte UM2 Nozzles Ausschau halten. Das hat sich schnell als ein Problem herrausgestellt da ich irgendwann die Nozzle schön ins Druckbrett habe graben lassen, die jeweilige Nozzle ist jetzt hinüber und der jeweilige Oberfläche des Druckbretts zerkratzt.

Doch damit war der Spaß noch nicht vorbei, dem Drucker beigelegt war ein Halter für einen BLTouch Sensor am Hotend. Doch leider war dieser bei mir komplett verbogen, sodass ich einfach einen neuen gedruckt habe. Allgemein war der Antclabs BLTouch Sensor merkwürdig, für fast 40€ bekommt man hier nicht mal ein Kabel, um Mainboard mit dem Sensor zu verkabeln, stattdessen wird ein “Kit” beigelegt um seine eigenen Dupont Kabel zu crimpen. Für mich war das zum Glück kein Problem aber solche Crimpzangen sind, warum auch immer relativ teuer in Deutschland und für den Preis hätte man einfach einen Meter Kabel beilegen können was zwar nicht für alle 3D-Drucker passend wäre aber immerhin für den größten Teil davon.

Die ersten Drucke waren bereits nervenaufreibend da bereits wenige Millimeter Spielraum darüber entscheiden, ob der Druck am Bett ordentlich haftet oder zu sehr ins Druckbett gedrückt wird. Vor allem das ABL (Automatic Bed Leveling) über BLTouch raubte mir aber jeden Verstand da man hier nur sehr schwer das Druckbett selber kalibrieren kann, da ja eigentlich der Sensor das für einen übernehmen soll. Nachdem ich dann auch noch eine eigene Firmware kompiliert habe wurde es aber langsam besser.

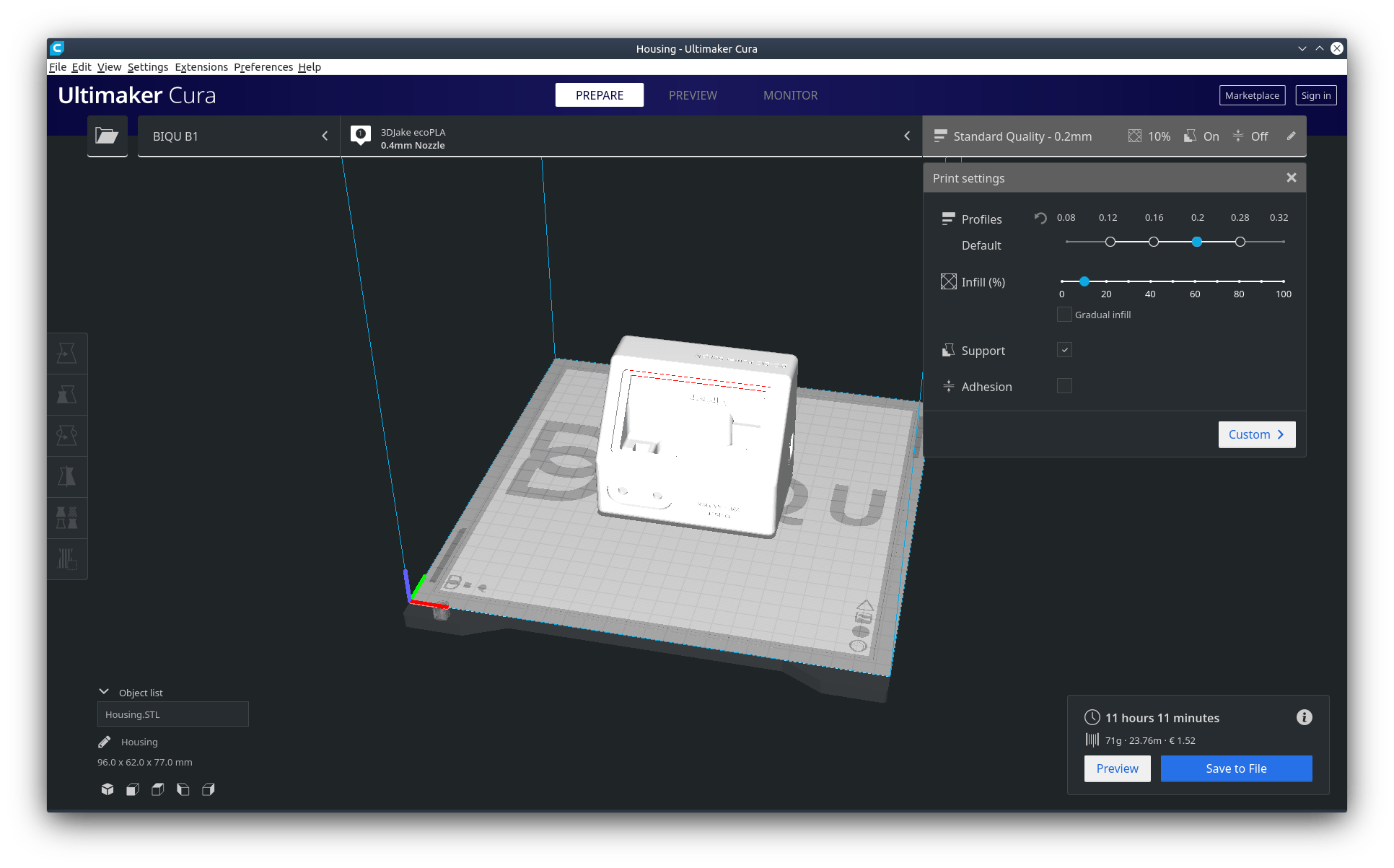

Als Slicer Software, um 3D CAD Objekte in 3D-Drucker Gcode umzuwandeln, habe ich mich übrigens für Ultimaker Cura entschieden, vor allem die Features wie Ironing für glattere Drucke an der Oberseite oder Gradual Infill sind wahnsinnig gut gelungen. Alternativen wären noch PrusaSlicer oder Slic3r. Es scheint aber das die zwei Slicer von den Firmen Ultimaker und Prusa hier klar Vorreiter in neuen praktischen Funktionen sind im Gegensatz zu dem komplett eigenständigen Projekt Slic3r.

Ein weiteres Problem kam sehr schnell auf: Das Plastik Filament saugt Feuchtigkeit aus der Umgebung sehr schnell auf, vor allem in den kalten Tagen ein nicht zu vernachlässigbares Problem, weil zu feuchtes Filament zu Blasenbildung in der Nozzle führen kann und damit der endgültige Druck an Qualität verlieren kann. Um das Problem vorläufig zu bekämpfen habe ich mir eine verschließbare Box gekauft, wo ich die Filamentrollen mit Trockenheitsbeutel/Silicagel lagere, das hat leider den Nachteil, dass ich das Filament nahezu täglich wieder aufrolle und zurücklegen muss.

Nach ungefähr zwei Monaten ist mein Fazit das ich zwar im Voraus mich informiert hatte wie Zeitaufwendig dieses neue Hobby sein wird, trotzdem hat mich der Zeitaufwand nahezu erschlagen mit allen möglichen Probleme. Spielraum nach oben gibt es auch noch genug, so bin ich dabei noch einen Filament Guide zu bauen, Octoprint mit Plugins aufzuwerten wie z.B. den automatischen Erkennen von Spaghetti, sodass ich den 3D-Drucker auch mal unbeaufsichtigt arbeiten lassen kann. Was ich auch noch gar nicht angesprochen habe ist das eigene designen von 3D Objekten z.B. über FreeCAD oder OpenSCAD, welches ich mir noch aneignen muss im nächsten Jahr und wodurch der 3D-Drucker endlich wirklich nützlich werden kann.

Am 29. Oktober 2018 gaben IBM und Red Hat bekannt das IBM sich alle Aktien von Red Hat zum Preis von 190$ (Börsenkurs zur Ankündigung: 116$), also insgesamt 34 Milliarden Dollar, kauft und sich damit Red Hat einverleibt.

Red Hat ist die derzeit größte Linux Firma der Welt und betreut nicht nur Linux-Distributionen wie das namens gebende Red Hat sondern auch CentOS, Fedora und CoreOS. Oben drauf beschäftigt Red Hat eine sehr große Zahl an Linux Entwicklern welche maßgeblich an Projekten wie Wayland, Xorg, Gnome, flatpak, GTK, systemd und vielen weiteren wichtigen Bestandteilen von Linux arbeiten. IBM wird jedoch wahrscheinlich am Cloud Provider Geschäft mehr interessiert sein, da sie auch dort versuchen wieder mehr Fuß zu fassen zwischen Google, Amazon, Microsoft und Alibaba.

Damit ist dieser Einkauf einer der Größten in der IT-Industrie und wirft eine Menge Angst auf. Was wohl nicht von irgendwo kommt, eingekaufte Firmen von IBM sind intern oft bekannt als “Blue Washing”, bei dem bestehende Prozesse der eingekauften Firma durch IBM Lösungswege ausgetauscht werden, völlig egal ob sie für diesen Fall besser sind oder nicht, zumindest bleibt der CEO von Red Hat weiterhin als dieser Aktiv. Bleibt die große Angst ab wann IBM die Open-Source Arbeit der unzähligen Linux Entwickler als “unnötig” einstuft und eindampft, wie es leider schon häufiger nach dem Einkauf von IBM geschehen ist.

Im Moment kann leider niemand genau sagen was wie Linux, wie wir es kennen, sich durch diese Einverleibung verändert wird. Im besten Fall erkennt IBM wie wichtig die Arbeit von Red Hat und all ihren Mitarbeitern ist um ein gutes Linux System aufzubauen. Im schlimmsten Fall wird IBM rigerös den roten Stift ansetzen und jede “unnötige” Arbeit streichen die Red Hat bislang in Kauf genommen hat für das Wohl von Linux.

Ich für meinen Teil werde meine Bestrebungen wegen einem Wechsel von Ubuntu auf Fedora, erst mal auf Eis legen und warten wie die Sache auf lange Sicht ausgehen wird. In der Zeit finde ich vielleicht eine passendere Linux-Distribution. Aber erst mal müssen sich noch Aktionäre und Investoren von Red Hat darüber einigen.

Update: 10.12.2020

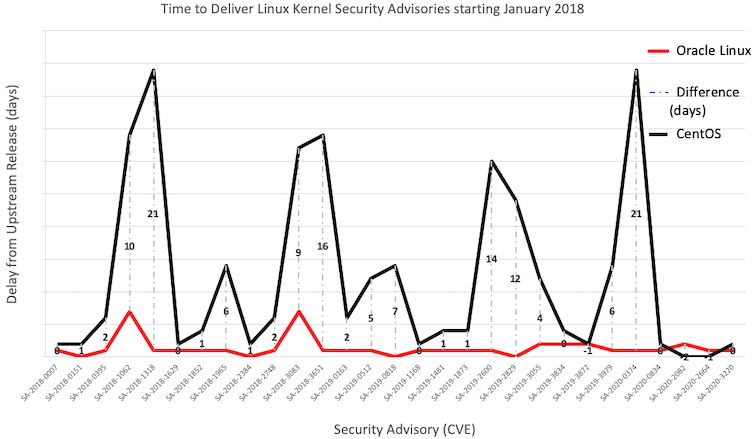

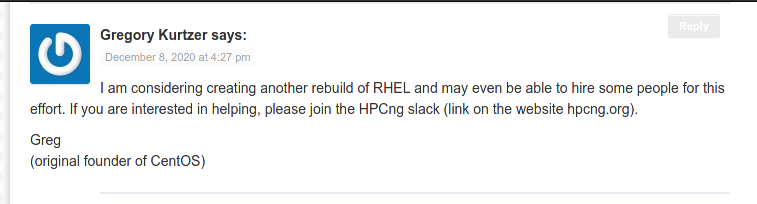

Am 8.12.2020 gibt es eine große Ankündigung von CentOS zu dem Thema. Nach 26 Monaten seit der Ankündigung zur Red Hat Übernahme scheint man nun Konsequenzen zu ziehen und “degradiert” CentOS zu einem Beta-Test von RHEL. Anscheinend hatte ein Erbsenzähler bei IBM bemerkt das einige Firmen lieber kostenlos CentOS nutzen anstelle für Lizenzen für RHEL zu zahlen.

Beginnend 2022 wird CentOS 8 auf eine Art rolling release umgestellt namens “CentOS Stream” und damit zwar immer noch sehr ähnlich zu RHEL aber eben nicht mehr 1:1 gleich. Genau genommen war das aber vorher schon nicht immer der Fall, CentOS hatte sich oft sehr lange Zeit gelassen für Security Updates, der Konkurrent Oracle Linux macht das zu einem seiner Pluspunkte gegenüber CentOS deutlich:

Während Oracle Linux sich als Ersatz positionieren (mit fragwürdigen Oracle Lizenzkosten), hat sich schnell Mitbegründer von CentOS Gregory Kurtzer zu Wort gemeldet:

Das neue Projekt hat bereits Forum und Namen bekommen: Rocky Linux

Man kann auch positives aus der Ankündigung herausziehen, wie zum Beispiel das Red Hat jetzt vielleicht endlich mal rolling releases massentauglich machen könnte und den Mythos brechen könnte das diese nicht zuverlässig laufen und sofort kaputtgehen. Oder das man endlich mal wieder frischen Wind in die RHEL forks gebracht hatte, nachdem CentOS seit Jahren eher träge mit Entwicklung und Updates sich hinter RHEL herschleppen. Realistisch betrachtet werden aber die meisten sich eher nach Alternativen umschauen und vielleicht bei Rocky Linux oder Oracle Linux hängen bleiben oder sich ganz Red Hat abwenden und eher Richtung SUSE/OpenSUSE umschauen.

Vor fast genau 10 Jahren hatte ich mir ein kleines Indie-Spiel namens Minecraft gekauft. Einige Jahre später hat sich aus einem kleinen Indie-Spiel eines der beliebtesten Spiele der Welt entwickelt für den Microsoft ganze 2,5 Milliarden Dollar in 2014 hingeblättert hatte.

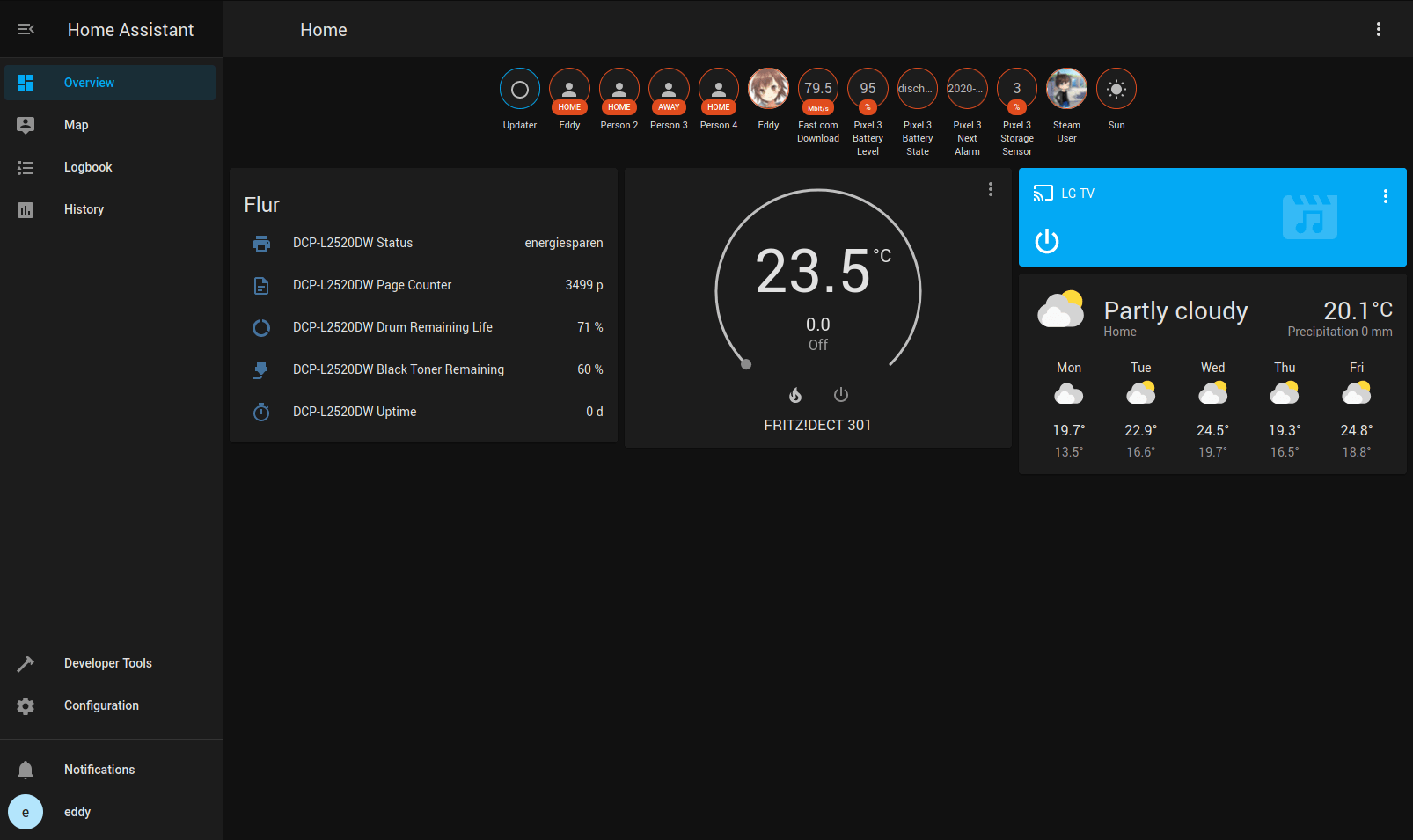

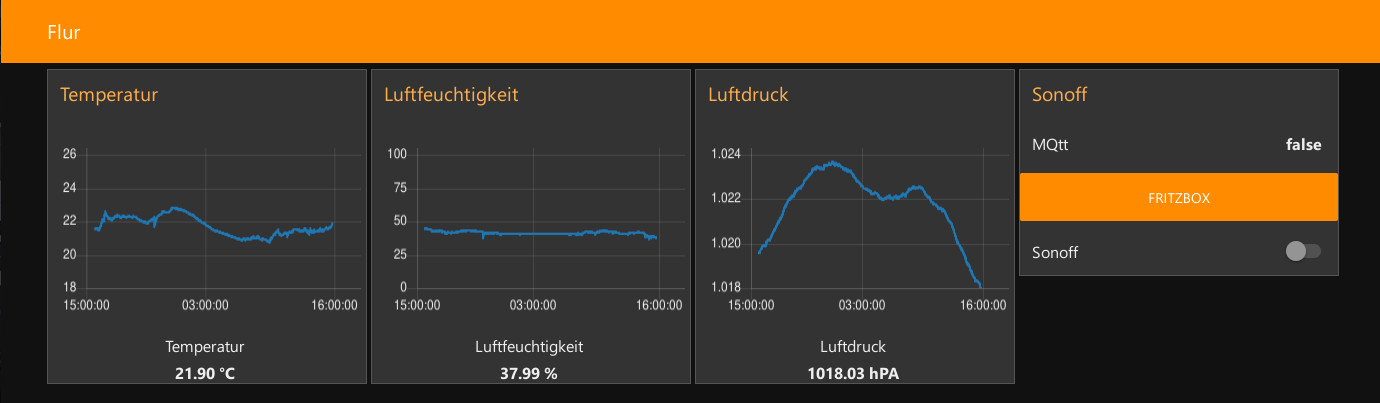

In meinem letzten Blog Eintrag hatte ich erzählt wie ich mir einen neuen Raspberry Pi zugelegt hatte und heute kommt nach einigen Tests nun endlich der Erste richtige Verwendungszweck, den ich mir überlegt hatte. Über das Thema Heimautomatisierung hatte bestimmt schon jeder mal mit rosaroter Brille nachgedacht und sich die tollsten Möglichkeiten überlegt und einige proprietär Heimautomatisierung Software kommt diesem Wunsch oft sehr nahe (z. B. Google Home Assistant). Ich hatte jedoch etwas anderes im Kopf: Open-Source und ohne externe Cloud sollte mein Heim laufen. Schnell wird man im Netz fündig was es für Alternativen gibt und stolpert über viele Begriffe und ich habe einige getestet und wollte diese grob präsentieren.

Home Assistant (ehemals hass.io)

Vorneweg: Letztlich habe ich mich für Home Assistant entschieden um die meiste Arbeit zu erledigen und da fängt es schon an, man kann die verschiedene Heimautomatisierung Software auch im Tandem nutzen und so das Beste aus allen Welten zu verbinden. Der größte Vorteil an Home Assistant ist wie groß die Community ist, die sich darum gebildet hat und derzeit 1652 “Integrations” für alles Mögliche anbietet. Außergewöhnlich ist auch wie konsistent und flüssig die Oberfläche inzwischen ist und Beispielweise sogar auch automatisch erkannt hat das mein Betriebssystem ein dunkles Thema bevorzugt.

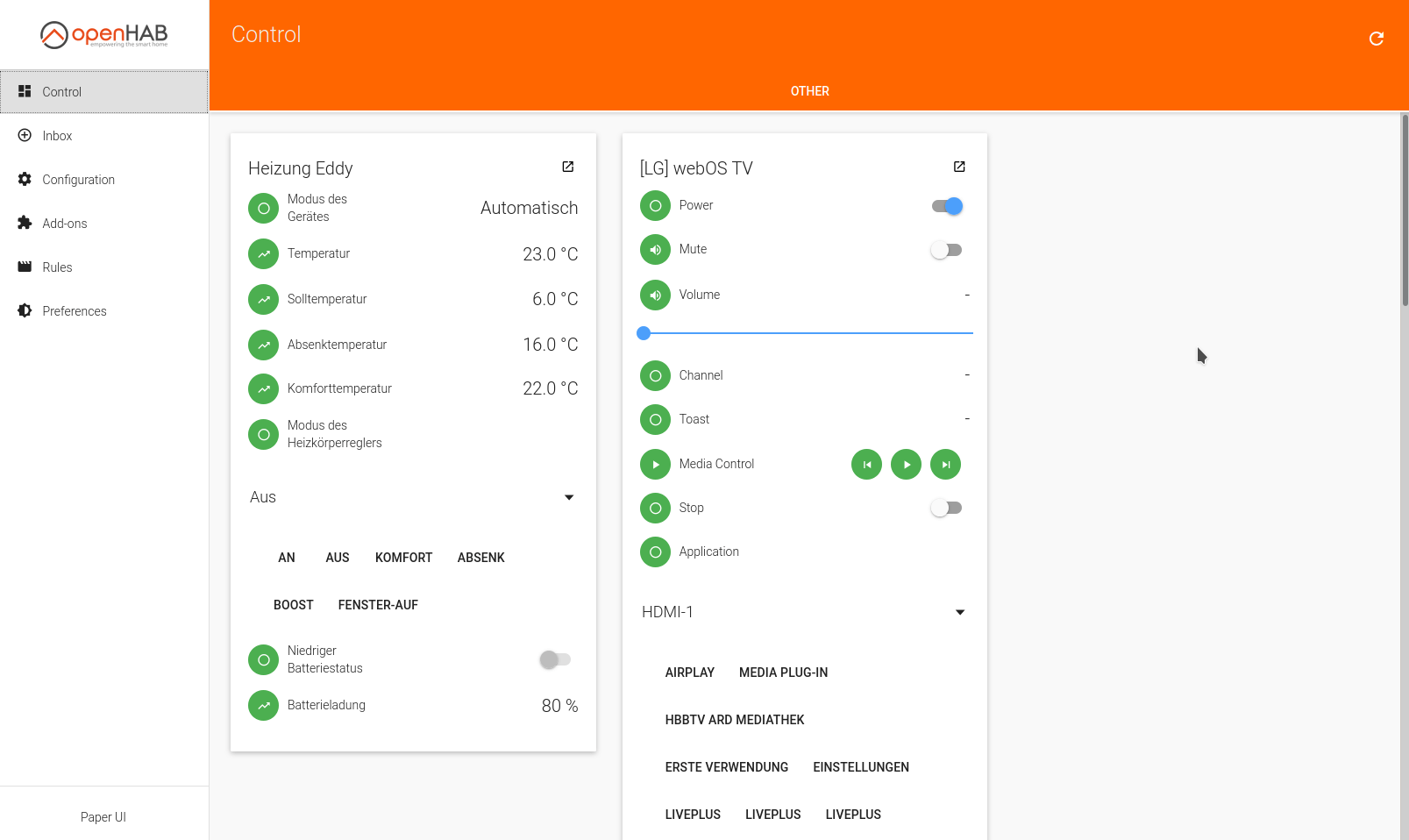

Die Installation verlief jedoch etwas problematisch wenn man den Weg über Docker geht, anstatt die fertigen Raspberry Pi Images zu nehmen, dafür muss man keine speziellen Rechte für den Konfigurations Ordner einstellen, wenn man diesen als Volume aus dem Container raus führt. Direkt nach der Installation erkannte Home Assistant sofort drei “smarte” Geräte: Mein LG TV, AVM Dect 301 Heizthermostat und mein Laserdrucker Leider erkannte Home Assistant das TV Gerät über Homekit anstatt der nativen LG webOS Integration und den Drucker über das generische Netzwerkdruckerinterface statt der Brother Integration, in beiden Fällen bekam ich mehr Funktionalität durch den Wechsel auf die “native” Integration.

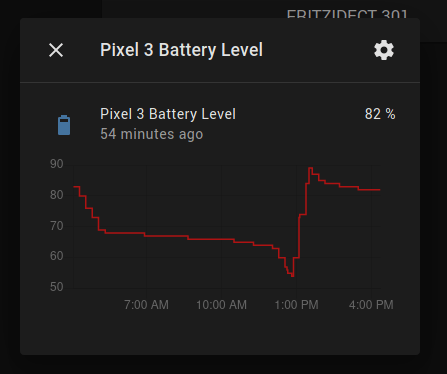

Durch einige Einträge in der Konfigurations Datei im YAML Format konnte ich einfach und schnell die Funktionalität schnell erweitern und hatte innerhalb einer Stunde bereits automatische Präsenzerkennung von Personen mithilfe ihres Handys im WLAN Netz, Logging der Downloadgeschwindigkeit im stündlichen Intervall oder Notifications auf meinen Matrix Server für Handy Benachrichtigungen (Discord, Telegram, Mastodon, Rocket.Chat oder Signal sind auch möglich). Wenn Home Assistant neue Geräte erkennt, dann bekommt man im Dashboard eine Meldung unter “Notifications” um diese gleich einrichten zu können.

Es gibt verschiedene Oberflächen zur Auswahl aber das automatische Dashboard macht bereits einen sehr guten Eindruck aus dem Stand heraus. Außerdem bietet die Home Assistant App an einige Zustände, wie zum Beispiel Akkustand oder der nächste Wecker, des Handys an Home Assistant zu schicken.

OpenHAB

OpenHAB ist das Ur-Gestein der Heimautomatisierung Lösungen und entstand 3 Jahre vor Home Assistant und das merkt man leider auch. In der neuesten Version 2 gab es eine neue Oberfläche namens “Paper UI” welche das alte “Basic UI” verbessern soll, zusätzlich gibt es mit “OpenHUB” noch eine Oberfläche speziell für Tablets. Nach der Installation wird man gefragt welche Oberfläche man bevorzugt und gibt Empfehlungen für Anfänger.

OpenHAB listet neue Geräte in der “Inbox” auf und erkannte aus dem Stand heraus meinen LG TV und das AVM Dect 301 Heizthermostat. Mit “nur” 394 Add-ons bietet OpenHAB auch eine große Auswahl und deckt die wichtigsten Dinge ab.

Die Installation hat sich dagegen um einiges einfacher gestaltet, auch wenn man die Konfigurations Ordner Rechte anpassen muss, außerdem gibt es viele Anleitungen, um OpenHAB auf so ziemlich allem zu installieren inklusive fertiger Raspberry Pi Images. Leider sind die add-ons manchmal etwas träge und das ganze Konzept hat eher Bastelcharme. Ein Bonus ist jedoch das die OpenHAB Apps im F-Droid Store erhältlich sind, bieten jedoch keine Funktion zum teilen von z.B. Akkustand oder dem nächsten Wecker mit der Heimautomatisierung Software wie bei Home Assistant.

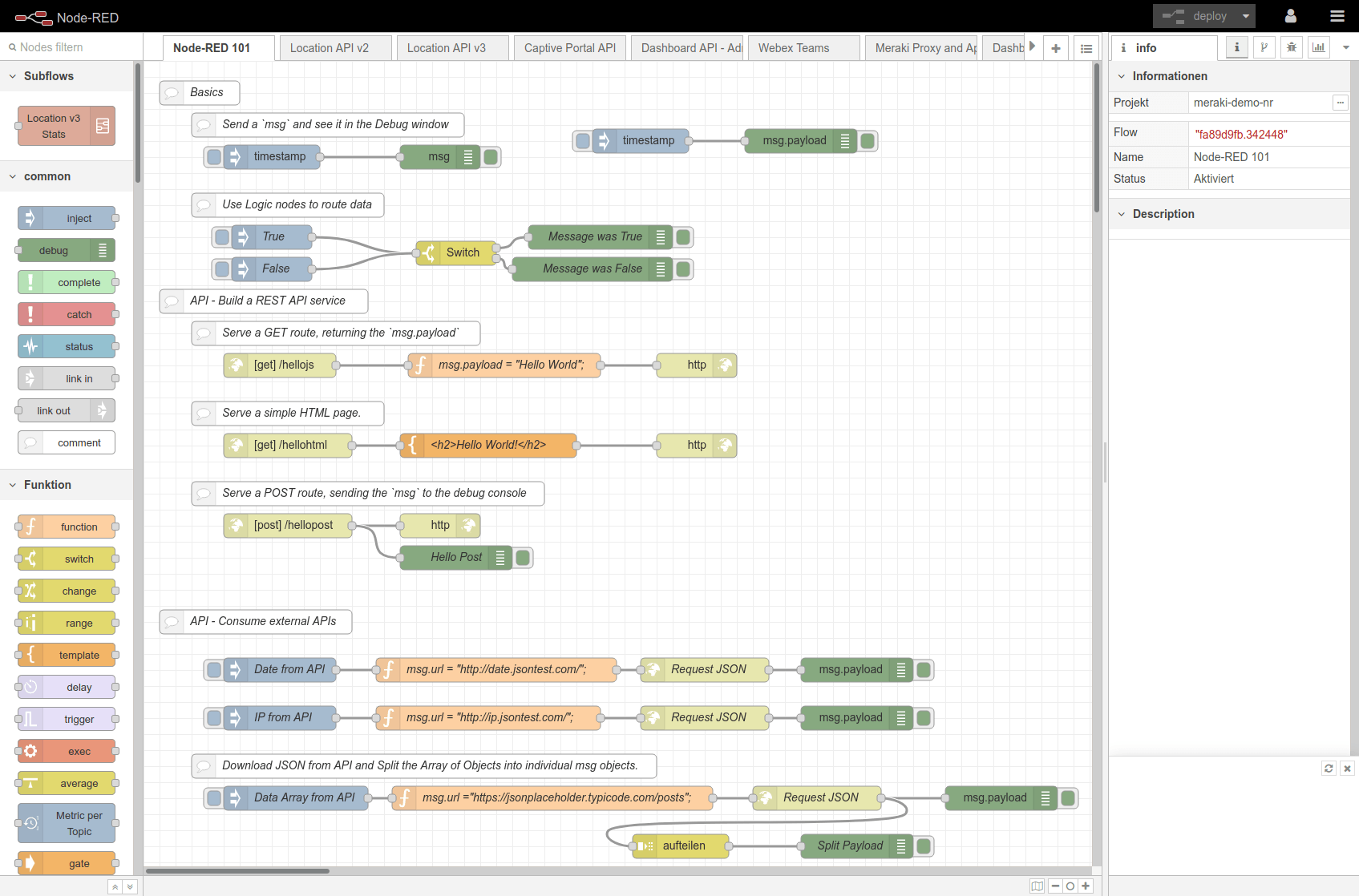

Node-RED

Node-RED fällt ein wenig aus dem Rahmen den eigentlich ist Node-RED nur eine “Rule Engine” und steuert Ereignisse/Regeln, dafür umso besser als jeder andere Konkurrent. Solche Ereignisse werden in sogenannten “Flows” gesteuert die man sich relativ einfach zurecht klicken kann.

Vor allem für Benutzer mit weniger programmier- technischen Hintergrund sicherlich sehr nützlich über viele Add-ons kann man viele Funktionen nachrüsten wie z. B. Integration zur Fritz!Box. Jedoch muss man dies alles händisch konfigurieren und dann als Flows einrichten, eine automatische Konfiguration oder nützliche Beispiele wie bei Home Assistant oder OpenHAB fehlen komplett.

Seit kurzem gibt es auch die Möglichkeit ein UI Dashboard einzurichten, das muss man jedoch etwas umständlich per Flows manuell einrichten, was etwas eigensinnig am Anfang ist. Allgemein ist das UI Framework eher Beiwerk und nicht das Hauptaugenmerk bei Node-RED, weswegen Node-RED gerne als Ergänzung zu Home Assistant oder OpenHAB genutzt wird.

Ergänzung: MQTT (Broker)

Wer seine Heimautomatisierung selber in die Hand nimmt, wird schnell über MQtt stolpern bzw. den open source Broker Mosquitto. Über das MQTT Protokoll können “Sender” sowie “Empfänger” (typischerweise IoT Geräte) unkompliziert Daten an einen MQTT Broker (zentraler Server) austauschen. Die Daten landen dabei in frei wählbaren “Topics” die an ein REST-API erinnern wie z. B. /drinnen/schlafzimmer/sensor/temperatur. Ein Empfänger kann jetzt Topics abonnieren beispielweise über /drinnen/schlafzimmer/sensor/* und wird sofort benachrichtigt, wenn z. B. neue Daten über .../temperatur oder .../luftfeuchtigkeit im übergeordeneten Topic Schlafzimmer Sensoren eintreffen.

Leider ist die beliebteste MQTT Broker Mosquitto jedoch standardmäßig extrem lax konfiguriert und man muss erst sehr umständlich eine Rechteverwaltung selber einrichten. Listen mit komplett offenen und öffentlichen Mosquitto Servern findet man leider zur Genüge im Internet.

Ergänzung: ZigBee

Wer mit smarten Leuchtmittel (z. B. Philips Hue oder IKEA Trådfri) liebäugelt, wird oft eine Art “Bridge” oder “Hub” benötigen um mit dem Leuchtmittel zu kommunizieren. Dieses Stück (oftmals teurer) Hardware kann man sich aber getrost schenken, wenn man sich einen ZigBee USB-Stick für seine selbst gehostete Heimautomatisierungs Lösung besorgt und damit stattdessen die IoT Leuchtmittel direkt anspricht.

ZigBee ist im Grunde eine Low-Energy Version von WLAN, das hat jedoch auch den Nachteil das in Gebieten mit sehr vielen WLAN-Netzen auch die Sendeleistung von ZigBee runtergeht. Es gibt auch einige Leuchtmittel welche mit anderen Protokollen arbeiten wie Z-Wave oder Bluetooth, genauso gibt es außer Leuchtmittel noch andere IoT Geräte mit ZigBee Anbindung.

Fazit

Die große Auswahl an open source Heimautomatisierung Lösungen macht es nicht leicht das Richtige für sich zu finden. Für den Moment versuche ich Home Assistant voll auszunutzen und werde wahrscheinlich in Zukunft langsam neue Sensoren und IoT Geräte nachpflegen, welche ich hoffentlich in einem zweiten Blog Eintrag präsentieren kann.

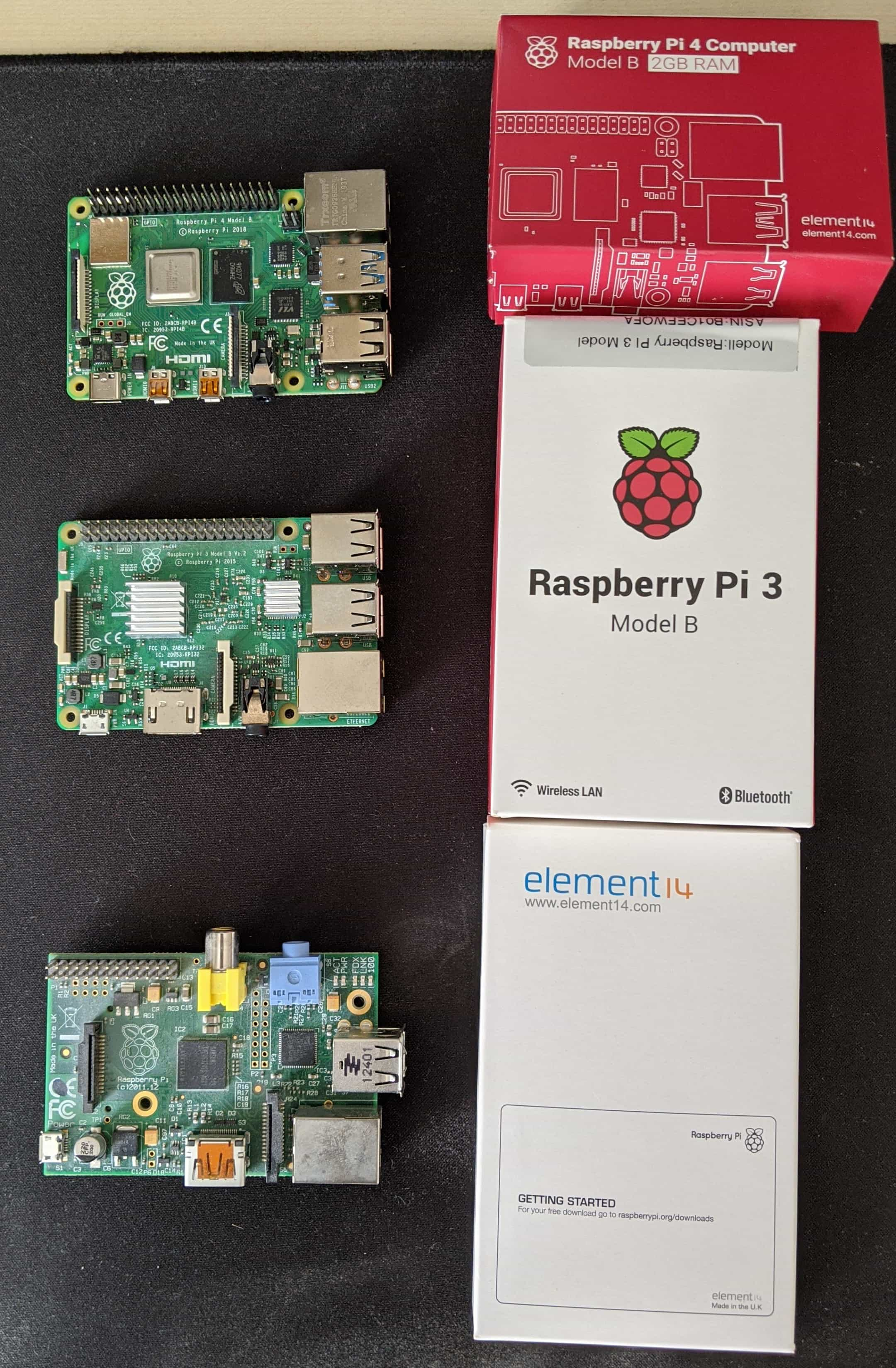

Nachdem ich meine letzten beiden Raspberry Pis Version 1 und 3 durch Eigenverschulden gebricked hatte, kam ich auf die Idee endlich mal Version 4 des beliebten Einplatinencomputers zu kaufen. Die Vorteile gegenüber dem letzten Model lagen klar auf der Hand:

Vor allem die Umstellung von Ethernet und USB Hub auf eigene PCIe Lanes macht den Raspberry Pi 4 nun endlich als Mini-NAS nützlich. Aber es gibt aber Nachteile:

Den letzten Punkt kann man jedoch seit dem 15. Mai 2020 beheben, knapp 11 Monate nach Release der neuen Version 4 des Einplatinencomputers tauchte auf GitHub eine Beta-Version der Firmware für den EEPROM auf der das booten über USB erlauben würde. Bis zu diesem Tag musste man immer über eine Micro-SD Karte erst mal den Bootloader starten und danach auf eine System-Partition auf USB verweisen, aber jetzt geht das ganz ohne extra Micro-SD Karte und nativ).

Das Aufspielen des EEPROM Updates ist derzeit noch mit etwas Mühen verbunden:

Man braucht eine Micro-SD Karte mit Raspbian und aktuellen System über apt update, apt upgrade und rpi-update. Nach einem Reboot kann man jetzt im rpi-epprom Paket auf den Beta-Zweig wechseln, dafür editiert man die Datei /etc/default/rpi-epprom-update von

FIRMWARE_RELEASE_STATUS="critical"

auf

FIRMWARE_RELEASE_STATUS="beta"

Und nun spielt man die neueste Beta Firmware über rpi-eeprom-update auf, dafür sucht man sich die aktuellste Version der pieeprom-*.bin Datei im Verzeichnis /lib/firmware/raspberrypi/bootloader/beta/. Zum heutigen Zeitpunkt (26.05.2020) sieht der ganze Befehl so aus:

sudo rpi-eeprom-update -d -f /lib/firmware/raspberrypi/bootloader/beta/pieeprom-2020-05-15.bin

Nach einem abschließenden Reboot sollte der Raspberry Pi 4 nun endlich von USB booten können und die Micro-SD Karte für andere Zwecke verwendet werden. Das Einzige, was noch fehlt, ist die Bootloader Firmware eines Laufwerks eurer Wahl (z.B. USB-Stick oder SATA SSD/HDD über USB Adapter) anzupassen:

Schreibt zuerst das neueste Raspbian auf euer Laufwerk und kopiert dann alle *.elf und *.dat Dateien aus dem /boot Verzeichnis eures gerade genutzten Raspbian von Micro-SD zum /boot Verzeichnis des USB Laufwerks. Bei der Gelegenheit kann eine leere Datei namens ssh angelegt werden im /boot Verzeichnis so fern man direkt über SSH auf den RasPi zugreifen möchte.

Doch lohnt sich die Mühe? Ich habe die neue Beta EEPROM Firmware gleich mal getestet und eine SanDisk 16GB Micro-SD Karte, einen SanDisk 32GB USB 3.0 Stick, eine SanDisk 120GB SATA SSD und eine Seagate 2TB 2,5” SATA SSD über einen ELUTENG USB 3.0 zu SATA Adapter im Benchmark gegeneinander antreten lassen. Zum Einsatz kam die Benchmark Kollektion von storage.jamesachambers.com welche DD, HD Parm, IOZone und FIO vereint.

| Gerät | Disk Read | Cached Read | Write | IOPS Read | IOPS Read |

|---|---|---|---|---|---|

16 GB Class 10

|

41 MB/s | 40 MB/s | 11,6 MB/s | ~2500 IOPS | ~770 IOPS |

32 GB USB 3.0

|

95 MB/s | 48 MB/s | 76 MB/s | ~1700 IOPS | ~870 IOPS |

2TB 2,5" SATA 3

|

110 MB/s | 270 MB/s | 72 MB/s | ~2060 IOPS | ~430 IOPS |

120 GB 2,5" SATA 3

|

300 MB/s | 200 MB/s | 140 MB/s | ~18400 IOPS | ~9500 IOPS |

Mit einer schnelleren Micro-SD Karte hätte ich wahrscheinlich an der maximalen Grenze von 50 MB/s kratzen können, weder SD-Karte noch USB-Stick oder HDD bekommen jedoch ordentliche IOPS Werte hin. Dafür fühlt sich das System auf einer SATA SSD erstmal richtig flott an, vor allem wenn man über apt Pakete installiert dauert, das keine halbe Ewigkeit mehr, sondern geht, genauso schnell wie auf einem richtigen Desktop oder Laptop. Ein weiteres Plus ist das SSDs wear-leveling besitzen während der Großteil aller SD Karten und USB-Sticks das nicht haben, außerdem kann man selbst ohne wear-leveling eine viel längere Laufzeit erwarten gegenüber den billigeren Flash-Chips in SD Karten und USB-Sticks.

Leider hatte ich keinen schnellen USB 3.1 Stick zur Hand, Benchmarks zeigen jedoch auf das man über einen etwas teureren USB-Stick auch sehr schnell ans Ziel kommt.

Trotz Beta-Status lief das EEPROM Firmware Update sehr gut bei mir, die ersten Bug-Fixes trudeln auch bereits ein. Sobald die Firmware als stabil gekennzeichnet wurde, wird es auch einfacher diese aufzuspielen und ein einfaches ‘rpi-update’ sollte in einem zukünftigen Update genügen.

Seit es diesen Blog gibt, nutze ich Semantic-UI als CSS Framework um die Seite zu gestalten. Dabei habe ich Semantic-UI so lieb gewonnen das ich es fortan in jeder Webseite eingesetzt habe. Zuerst hab ich nur noch einen Ersatz für Bootstrap gesucht, welches bis heute immernoch eines der beliebtesten Toolkits ist um Webseiten zu gestalten.

Leider gibt es jedoch seit 2018 keine Updates mehr zu Semantic-UI, es wurde still um das Projekt und es werden Issues darüber geschlossen. Also haben sich einige Mitglieder in der Community zusammengesetzt und einen Fork erstellt: Fomantic-UI Dieser hat das Ziel irgendwann wieder in das Hauptprojekt einzufliesen, auch wenn es derzeit eher so aussieht als würde das noch passieren.

Also habe ich mich nun endlich dazu entschieden auch meinen Blog umzustellen mit Commit 19e3abe und dabei auch gleich ungenutzte Dateien entfernt und jQuery auch ein Update verpasst. Von der Umstellung sollte man nichts merken, dafür kann ich mich in Zukunft über neue Features freuen die in den Blog einbauen kann wie z.B. Font Awesome 5.12.0 Icons (Semantic-UI ist derzeit bei Font Awesome 5.0.8) oder Tertiary Buttons.

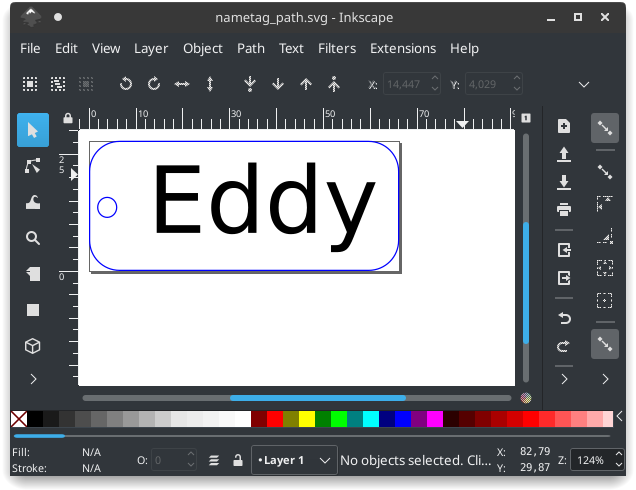

In meinem letzten Blog Eintrag hab ich bereits erwähnt das es im Hackspace einen CO2 Lasercutter gibt. Heute habe ich endlich mal mit diesem rumexperimentiert und als Ziel gesetzt ein Namensschild für meinen Schlüsselbund zu erstellen.

Als erstes hab ich rudimentär in Inkscape ein gerunndetes Rechteck mit meinem Namen erstellt. Anhand der Farbe wird der Laser später entscheiden wie viel Power er benutzt und ob diese ausreicht um das Material zu durchdringen. In meinem Fall sollen blaue Pfade das Material durchschneiden und schwarze nur gravieren.

Nach einer Einweisung von einem anderen Hackspace Mitglied, durfte ich nun auch selber den Laser bedienen und musste auch erst mal einige Test Durchläufe machen bis ich ein gewünschtes Ergebnis bekommen habe. Als Material hab ich hier 3mm Speerholz verwendet.

Nach ein wenig rumprobieren, hatte ich endlich die passenden Settings gefunden. Beim obersten Versuch habe ich den Laser den Text schraffieren lassen, wodurch es ungefähr 3 Minuten länger gedauert hat.

Alles in allem war es nur ein kleiner Test um mich mit derm Lasercutter vertraut zu machen. Die Namensschilder sind auch ein wenig zu groß geworden um sie an einen normalen Schlüsselbund zu hängen, aber jetzt weiß ich ja wie ich mir kleinere machen kann.

Hackspaces bzw. Hackerspaces oder FabLabs sind vor einigen Jahren geradezu wie Pilze aus dem Boden geschossen, jede größere Stadt hatte mindestens einen eröffnet. Vor allem auch durch den Chaos Computer Club (CCC) wurden viele lokale Vereine gegründet die ähnliche Räumlichkeiten bereitstellen.

Vor etwas mehr als einen Monat hab ich mich nun endlich auch getraut in einem meiner lokalen Hackspaces vorbeizuschauen und mir das selber mal anzuschauen. Dafür besuchte ich die Binary-Kitchen welche seit 7 Jahren in Regensburg besteht und eigene Räumlichkeiten anbietet für Vereinsmitglieder und außenstehende. Der Name kommt unter anderem davon das dort auch leidenschaftlich gerne gekocht wird, es gibt aber auch andere Interessen abseits von IT-Themen wie einen eigenen Garten oder eigene Bienenstöcke. Der Verein hat auch andere Vereine wie Regensburg Repariert oder die Amateurfunker in Regensburg eingegliedert. Interessanterweise gehört die Binary-Kitchen derzeit jedoch nicht offiziell zum CCC als “Erfa-Kreis”, trotz großer Nähe zu diesem.

Jeden Montag Abend werden gerne Führungen dort angeboten durch die 3 größeren Räume: Einer “Lounge” mit angegliederter Küche, im Keller ein Labor mit Lötstationen, 3D-Druckern und Amateurfunker Equipment und auf der gegenüberliegenden Straßenseite eine Werkstatt mit CNC Fräse, Lasercutter und anderem Werkzeug. Vor allem der 80W CO2 Lasercutter um unter anderem Holz oder Plexiglas über SVG Dateien “auszuschneiden” hat es mir angetan, in einem zukünftigen Blog-Eintrag wird es mehr Informationen zu ersten Projekten damit von mir geben. Einige Beispiele was man aus Holz machen kann, findet man hier.

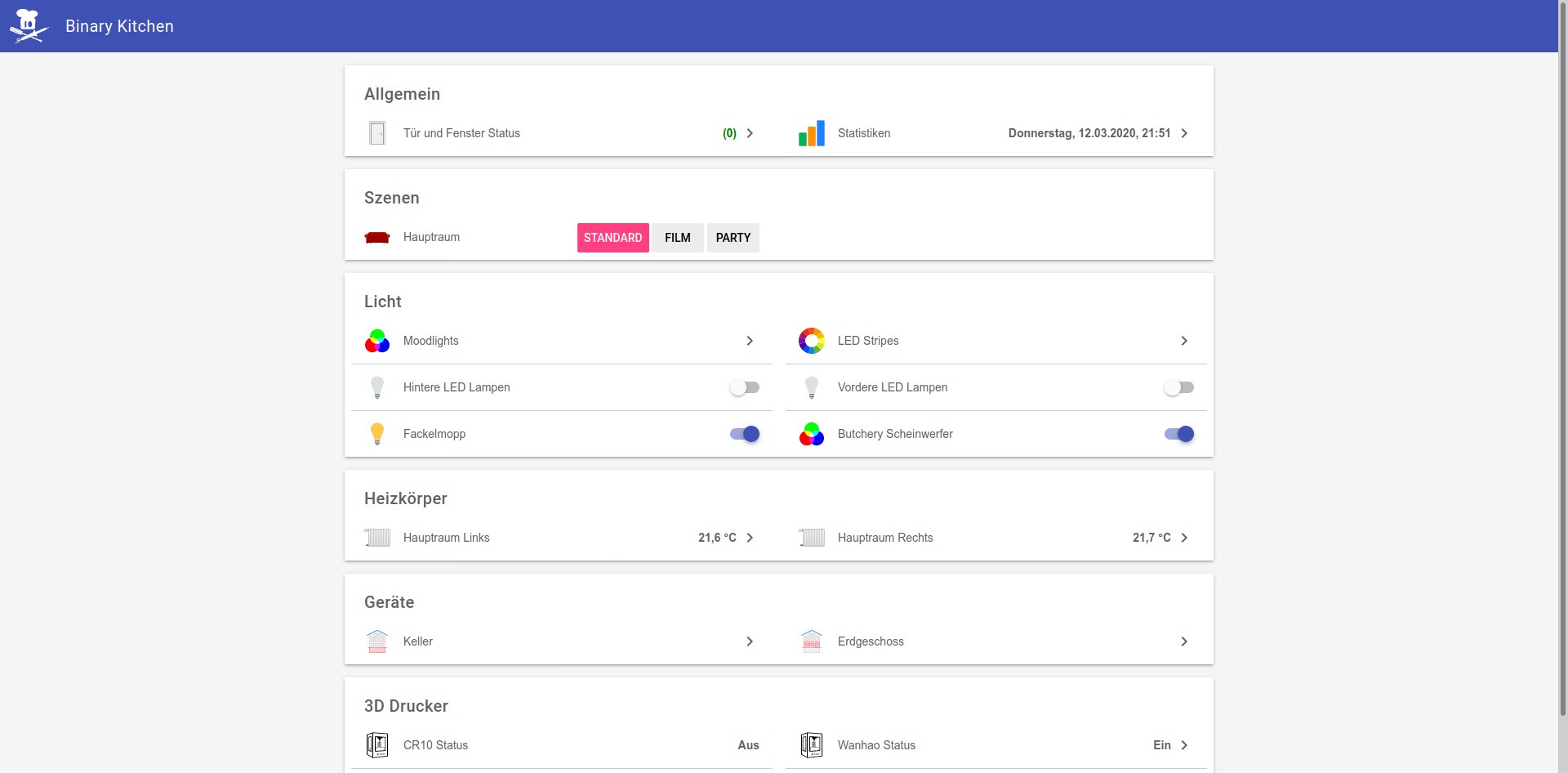

Auch spannend für mich ist der Grad der Heimautomatisierung welche man dort aufgebaut hat, auch komplett offline ohne Cloud Anbindung. Im Hauptraum gibt es viele verschiedene Lampen welche man über ein OpenHab Webinterface ein-/ausschalten kann oder teilweise sogar die Farbe umstellen kann. Der Kompressor in der Werkstatt wird nach einer bestimmten Uhrzeit als Lärmschutzgründen abgeschaltet, der Lasercutter geht erst an wen ein passendes Fenster zur Lüftung offen ist oder das Aufzeichnen von Temperaturen oder Feinstaub in der Luft. Außerdem gibt es in beiden Gebäuden Monitore an den Wänden speziell, um das OpenHab Interface anzuzeigen.

Das Haupt-Gebäude hat auch eine interessante Türsteuerung: Vereinsmitglieder können die Tür per App öffnen und von innen gibt es eine Ampel-ähnliche Steuerung.

Anhand des Status der Tür hängen auch andere Heimautomatisierungen ab, so laufen die Lampen im Hauptraum abends auch, nur wenn die Tür offen ist oder die Heizungen schalten sich ab wen niemand anwesend ist.

Programmierer sind bekannt dafür viel Kaffee zu trinken und unter Studenten ist auch Mate sehr beliebt, aber eigentlich ist beides nicht mein Geschmack. Auf der Suche nach einem passenden Ersatz bin ich letztes Jahr bei einem Getränk gelandet, welches ich vorher immer leicht belächelt habe: Tee.

Ich kannte Tee oft nur als Früchteaufguss oder viel zu über süßten Eistee, Schwarztee war für mich meistens viel zu stark und bitter im Geschmack. Das änderte sich nach dem ich über den Teepodcast gestolpert bin, anschließend gab ich dem Tee noch mal eine Chance und probierte einige verschiedene Beutel-Tees aus dem Supermarkt durch. Ich bemerkte das es eine große Variation von Schwarztees gibt und blieb anschließend an der Assam Mischung Nero von Teekanne für lange Zeit hängen. An Tagen wo ich “leichteren” Tee haben wollte kam ich dann auf den Weißen Tee Mango-Zitrone, letztendlich trank ich jeden Tag mindestens eine Tasse Tee und hatte für jede Tageslaune den passenden Tee.

Inzwischen war ich komplett im Tee-Kosmos abgetaucht, als Bonus gab es gebundenes Koffein, welches sich langsamer bemerkbar macht, als ungebundenes Koffein in Kaffee und damit mir bekömmlicher ist. Nachdem ich bereits dem Beutel-Tee verfallen bin, ging ich auch mal in das lokale Teehaus in der nächsten Stadt und fand eine noch größere Variation von Tee in loser Form vor. Nach dem ersten Besuch kam ich noch weitere male immer wieder vorbei um mich auch mit Zubehör wie Teedosen, Kannen oder Kandis zum süßen einzudecken.

Nun auch dem losen Tee verfallen, fand ich auch meine Liebe zu Grünen Tee, vor allem die Mischung aus Mango und Bergamotte im Grünen Tee tat es mir sehr an. An der Schwarztee Front fand ich für mich die Mischung aus Darjeeling und Assam Tee genau passend.

Ab diesem Zeitpunkt war Tee schon lange nicht nur ein Getränk für mich, sondern auch ein Genussmittel. Der regelmäßige Besuch beim lokalen Teehaus, welches ihre Tees noch selber verfeinern, wurde zum Ritual. Ist der Tee mal nicht süß genug, gibt es eine große Auswahl an Alternativen zu normalen Zucker.

Die einzigen Tees, welche ich bis heute nicht verstehe, sind die Gewürztees von Yogi-Tee. Meiner großen Verwunderung findet man diese Tees jedoch nicht nur in jedem Supermarkt, sondern auch im oben beschriebenen Teehaus sehr prominent platziert.

Einen Nachteil gibt es dann jedoch zu erwähnen: Inzwischen habe ich so viele Teedosen und Tee-Beutel Packungen angesammelt das ich jetzt dabei bin ein neues Regal in der Küche aufzubauen, alleine nur für all den ganzen Tee.

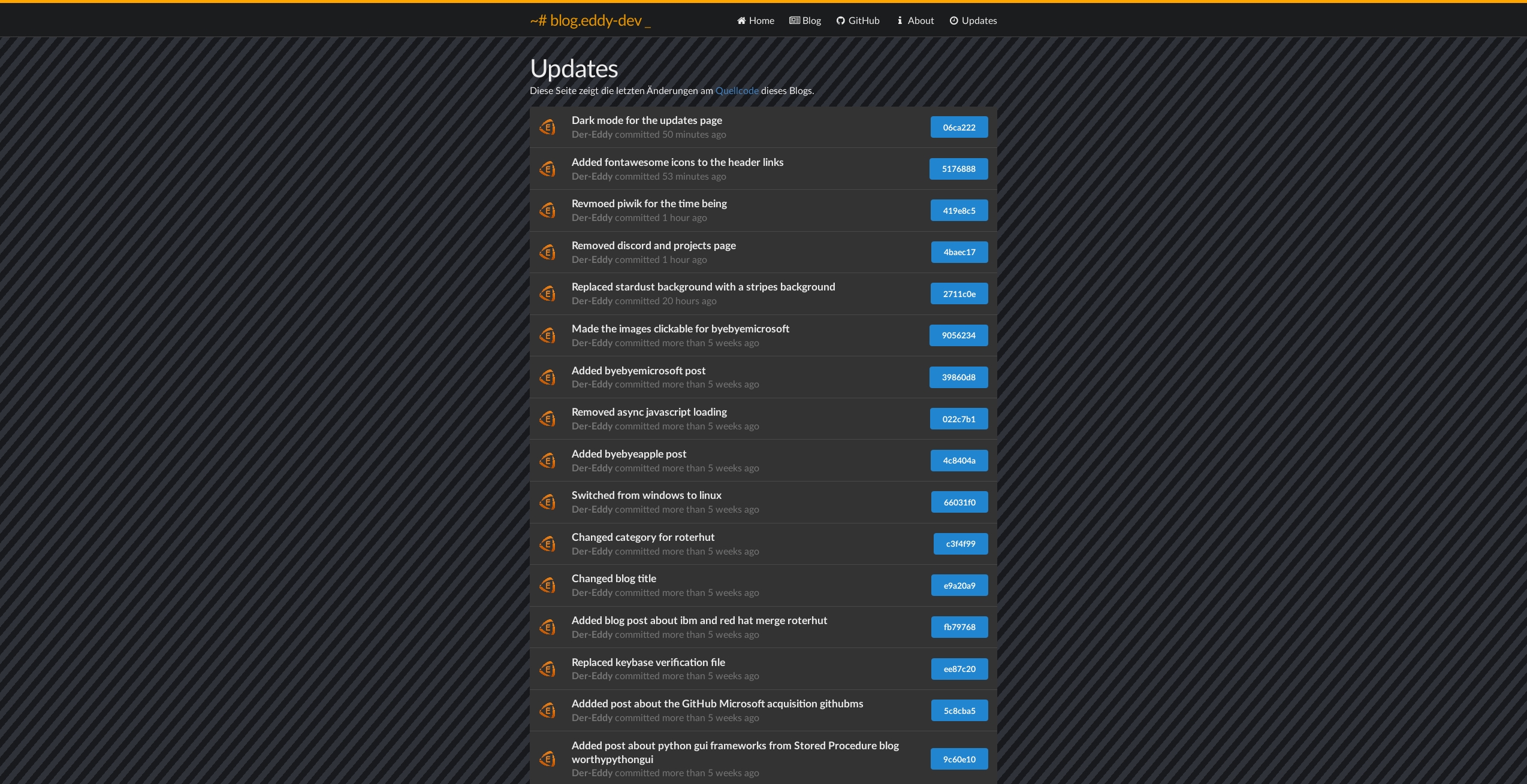

In 2017 habe ich diesem Blog ein dunkleres Design verpasst, siehe Neues Kleid. Damals dachte ich noch das es eine gute Idee wäre einen “Stardust” Hintergrund einzubauen damit es ein coolen Weltraum-theme bekommt. Ganz funktioniert hat das so nicht, dafür habe ich heute diesen ausgetauscht mit ein paar schrägen dunklen Strichen.

Vorher:

Nachher:

Zusätzlich hab ich die Navigations-Links im Header angepasst und Icons gegeben. Außerdem bekam die Seite für die git commit Historie ein dunkles Design:

Wie in meinem anderen Beitrag, zum Umstieg auf Android, bereits angedeutet wollte ich gerne zu Linux wechseln und konnte es niemals machen da ich immer an iTunes an Windows oder macOS gebunden war. Angefangen mit freeBSD Servern, übergehend zu Debian und Ubuntu Servern für Minecraft Servern habe ich bereits seit fast 10 Jahren in irgendeiner Form mit Unix zu tun gehabt. Arbeitstechnisch wurde ich, dann zu einem der wenigen in einer ehemaligen Firma, die sich überhaupt mit Linux auskannte und musste mich fortan um das Meiste bezüglich Debian und Ubuntu Servern kümmern. Nach Wechsel der Firma verlief die Leidenschaft zu Linux ein wenig im Sande über die Jahre wieder ein wenig. Trotzdem pflegte ich fast durchgehend einen persönlichen Ubuntu Server für Webserver und andere Spiele Reihen und musste meinen Microsoft Windows Workflow ein wenig anpassen dafür. Irgendwann hab ich gemerkt wie sehr ich Microsoft Windows umstellen musste damit ich überhaupt arbeiten konnte. Außerdem war ich unzufrieden mit der Update-Politik von Windows 10 und habe auch nie verstanden was die Leute so an Windows 7 feiern, Windows Aero war alles andere als Perfekt.

Zwischenzeitlich hatte ich auch mal zum Versuch Arch Linux auf einem Macbook installiert und es gefiel mir schon, jedoch fand ich es zu der Zeit noch nach zu viel Arbeit. Nachdem Arch Linux immer beliebter wurde und ich nach Ersatz für Windows gesucht hatte, wollte ich es noch mal versuchen mit Arch Linux. In einer virtuellen Maschine hatte ich also verschiedene Konfigurationen ausprobiert und die Installation noch mal durchgegangen bis ich anschließend komplett zum Fan wurde.

Die passende Linux Distribution

Der Trick von Arch Linux ist nämlich, das Arch Linux ohne grafischen Installer ausgeliefert wird und im Gegensatz zu fast allen anderen Linux Distributionen wie zum Beispiel Debian, Ubuntu oder Fedora keine fixen Releases hat, sondern als sogennantes “Rolling Release” fungiert und Updates von Upstream nur mit wenigen Tagen Abstand in die Main Repositories kommen. Das sorgt dazu das eine Arch Linux Installation immer sehr aktuell bleibt und man keine Monate oder Jahre warten muss auf neuere Versionen außerhalb von Sicherheitspatches. Viele Linux Nutzer sagen deswegen das Arch Linux nicht “stabil” ist und Programm Pakete mindestens mehrere Monate verfügbar sein müssen bevor sie erst als stabil und sicher gelten. Ich hatte jedoch in der Vergangenheit eher das Gegenteil erfahren, wenn ich versuchte einige neuere Pakete in z. B. Ubuntu einzupflegen und dadurch sogar die Upgrade-Installation oft schieflief. Letztlich ist das eigene System nur so stabil wie man es auch stabil macht, der Unterbau kann dabei helfen, aber es ist kein Alleinstellungsmerkmal für ein stabiles System.

Ein weiteres Problem von Linux Distributionen löst Arch Linux sehr gekonnt durch das AUR (Arch User Repository). Linux Distributionen kommen mit einem Paket Manager, welcher auf ein großes Archiv von Paketen Zugriff hat, welche man zusätzlich installieren kann anstatt wie bei Windows ausführbare *.exe Dateien aus dem Internet, aus teilweise dubiosen Quellen, laden muss. Das Problem taucht auf wen ein bestimmtes Programm, das man braucht nicht in den Paketquellen vorhanden ist, dann muss man ähnlich zu Windows entweder *.deb (Debian/Ubuntu) oder *.rpm (Fedora) Archive laden oder auf Snaps/Flatpack/AppImages setzen. Jedoch unterstützen nur Snap Pakete unter Ubuntu Updates und alle anderen müsste man fast immer manuell updaten. Sogenannte AUR Helper wie z.B. yay oder trizen binden sich nun nahtlos in den offiziellen Paket Manager ein und erlauben den Zugriff auf das AUR welches aus Binary Pakete (wie die offiziellen Paketquellen) besteht sowie Build/Compile Instructions um Pakete aus Git Repositories zu bauen. Das einzige Problem ist, dass das AUR durch die Community verwaltet wird und theoretisch Missbrauch erlaubt, weswegen jedem immer empfohlen wird vorher die Build Instructions anzuschauen bevor man blind etwas installiert.

Ein weiterer Pluspunkt für Arch Linux ist ihr Wiki, das Arch Wiki ist wahrscheinlich im Moment das größte Linux Wiki und geht um einiges mehr ins Detail als z. B. das Ubuntu Wiki, welches teilweise nur eine hübschere Man Page ist. Weil man die Installation auch anhand einer Anleitung im Wiki abschließen muss (sofern man sie nicht schon auswendig kann), lernt man dabei auch ein wenig über die Komponenten im Hintergrund und wie sie ineinander laufen. Natürlich ist es immer noch stark vereinfacht, es ist bei weitem kein LFS (Linux from Sratch) bei dem man noch weiter in jede Komponente gehen muss und sich aktiv mit Kleinigkeiten kümmern muss. In dem Sinne trifft Arch Linux für mich den perfekten Punkt zwischen der Einfachheit eines grafischen Installers oder schlicht überhaupt keinen wie bei LFS. Dadurch konnte ich auch mein System ein wenig genauer anpassen, anstatt meine Installation auf dem altbekannten ext4 Dateisystem aufzubauen, entschied ich mich für btrfs und eine Verschlüsselung mit LUKS und kann dadurch auf Features wie De-duplication oder Subvolume Snapshots zugreifen, welche bei ext4 nicht auf einer solchen low-level Ebene vorhanden sind.

In Kombination mit den neueren Paketen und “normalen” Standardkonfigurationen, anders als z. B. bei Manjaro, hab ich mich letztlich für Arch Linux entschieden. Fehlt nur noch eine passende Desktopoberfläche (DE / Desktop Environment) weil ich mich noch nicht mit einem barebones Terminal bzw. nur einem Window Manager anfreunden kann.

Die passende Desktopoberfläche

Unter Arch Linux kann man so ziemlich jede absurde Kombination installieren, ich habe mich aber erst mal mit den großen Drei auseinandergesetzt, XFCE, Gnome und KDE. XFCE findet seine Nische als leichtgewichtige Oberfläche, welche jedoch auf GTK aufbaut. Gnome war für mich eine absolute Katastrophe, nicht nur das es viel zu viele Ressourcen für zu wenig Nutzen verbraucht, sondern die Entwickler aktiv Features mit neueren Versionen entfernen. In meiner Anfangszeit hatte ich noch Spaß an Gnome 2 gehabt, mit Gnome 3 haben die Entwickler jedoch in meinen Augen nichts Ordentliches hervorgebracht. Blieb noch KDE Plasma übrig, welches Qt statt GTK nutzt und mit einem großen Umfang an Zusatzsoftware passend für KDE entwickelt.

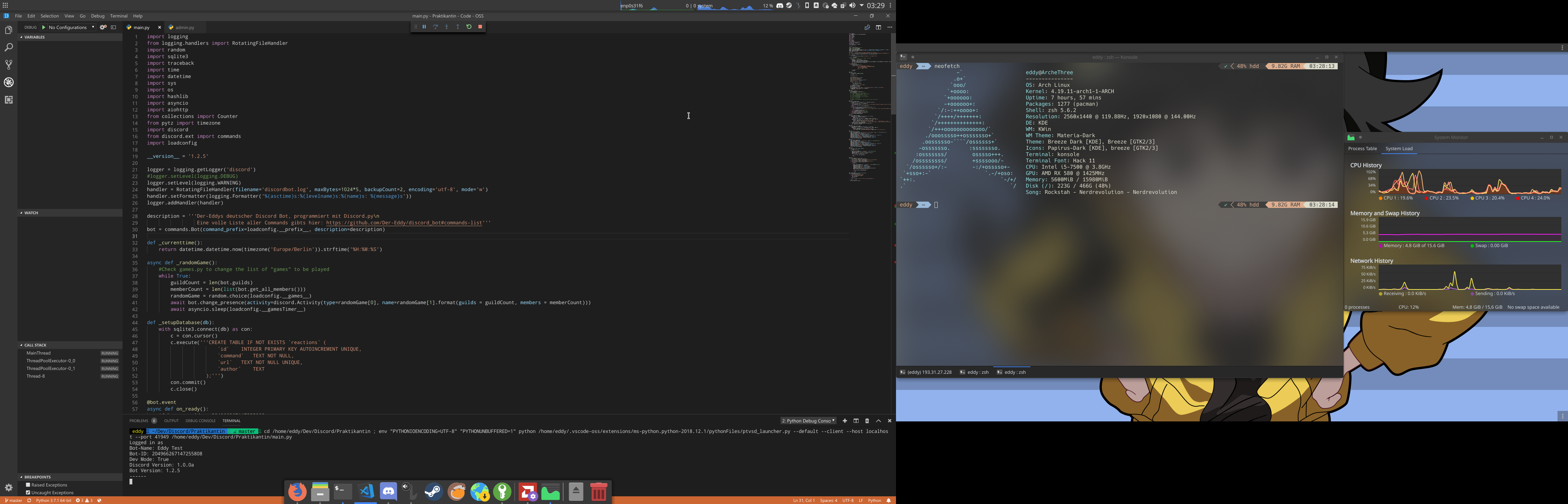

KDE hat mich wirklich überrascht mit seinem großen Umfang an Optionen und der Möglichkeit über kvantum das Design noch genauer anpassen zu können. Zusätzlich bin ich um einiges mehr zufrieden mit dem File Manager Dolphin als mit der GTK Katastrophe Nautilus. Ein weiteres cooles Feature von KDE ist auch KDE Connect, welches für eine ähnliche Erfahrung wie macOS <> iOS jedoch für Linux <> Android sorgt und Benachrichtigungen oder Dateien austauscht oder die Wiedergabe am Linux Computer automatisch stoppt bei einem Anruf.

Anschließend entschied ich mich letztlich für KDE Plasma anstatt dem überaus beliebten Gnome 3 oder Alternativen.

Spiele

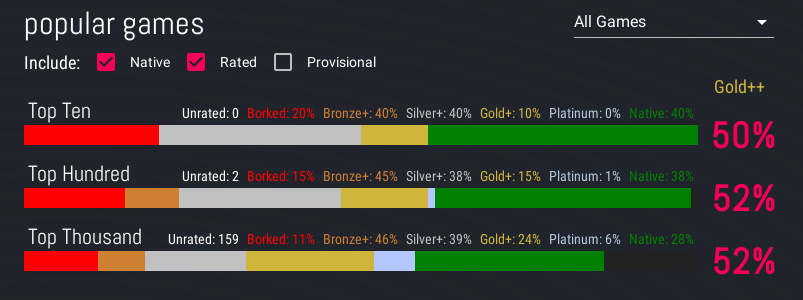

Ein weiteres Problem beim Umstieg waren für mich Spiele, der Großteil meiner Steam Bibliothek ist schließlich Windows exklusiv. Hier preschte Valve letztes Jahr mit Proton für ihre Vertriebsplattform Steam hervor. Proton ist eine Kombination aus Wine, Winetricks, DXVK und anderen Kleinigkeiten um Windows exklusive Spiele unter Linux spielbar zu machen. Eine Auflistung von Nutzer-Berichten zu Proton findet man unter Protondb. Dadurch kommt meine Linux Bibliothek plötzlich auf knapp 70% meiner Windows Bibliothek auf Steam und in Kombination mit meiner Playstation 4, kann ich trotzdem fast jedes Spiel, das ich auch spielen möchte, auch ohne Windows spielen. Zugegeben, ich bin kein großer Fan von großen Multiplayer Spielen wie Apex Legends (welche oft Anti-Cheat Maßnahmen nutzen, welche inkompatibel zu Proton sind) oder AAA Spiele (welche oft Denuvo Kopierschutz nutzen, auch größtenteils inkompatibel zu Proton) wie das neueste Assassin’s Creed. Wodurch die meisten Spiele, welche Probleme machen, schlicht wegfallen.

Nach etwa 4 Monaten mit Arch Linux und KDE Plasma bin ich mehr als zufrieden mit dem Wechsel und trauere Windows nicht mehr hinterher. Für einige Kleinigkeiten muss ich immer noch Windows hochfahren, das hält sich aber wirklich in Grenzen von ein mal pro alle paar Wochen.

Seit etwa 4 Monaten habe ich mein Apple iPhone 5s eingetauscht. Grund dafür war nicht das ich Apple nicht mehr mag oder unzufrieden war, mehr war es das ich endlich zu Linux wechseln wollte. Mein größtes Problem war nämlich immer, das es iTunes nicht für Linux gibt und man es auch nicht wirklich nützlich portieren konnte. Ohne iTunes verliert ein iPhone jedoch seinen Reiz, schließlich kann man sonst die Stock-Apps wie Musik oder Fotos adäquat nicht mehr nutzen.

Damals als ich zuerst ein iPhone 4 und danach ein iPhone 5s gekauft habe, war das Apple iPhone noch das absolute Spitzenmodell und war in Sachen Kamera Qualität immer allen weit voraus da sich Apple lieber darum gekümmert hat einen ordentlichen Bildsensor und große Blende zu verbauen als sich an Megapixeln aufzugeilen. iOS hatte auch bereits weit vor Android bereits ein Rechtesystem um Apps nicht gesamten Systemzugriff zu überlassen, derweilen erkämpfte sich Android gerade erst Marktanteile von Symbian.

Dabei hatte ich wirklich Freude gehabt mit meinem iPhone 5s, obwohl es schon über 5 Jahre alt war, bekam es immer noch (!!!) Updates für das aktuellste Betriebssystem iOS und mit iOS 12 gab es sogar Optimierungen, um das System noch schneller selbst auf meinem alten iPhone zu machen. Deswegen kann ich auch nie verstehen, wenn jemand meint das Apple absichtlich ihre alten Geräte unbrauchbar macht, das ist schlicht nicht wahr. Richtig viel Spaß hatte ich auch mit Jailbreaks, mit denen man super cool am System herumspielen konnte.

Weitere Screenshots aus einem alten Jailbreak Setup gibt es hier zu finden: https://imgur.com/a/dtvKk

Jedoch hat sich das inzwischen auch erledigt, Jailbreaks für iOS wurden immer rarer und inzwischen ist Jailbreak-Ikone Saurik zurückgetreten. Saurik hatte unter anderem den Jailbreak App Store Cydia sowie viele nützliche Tweaks wie Winterboard oder SBSettings über die Jahre entwickelt und immer für alle Versionen gepflegt. In Kombination mit dem Wunsch auf eine Linux Distribution zu wechseln habe ich mich also mal im Android Lager umgeschaut was es für Alternativen gibt.

Ein wichtiger Punkt für mich war, dass das Gerät mindestens 3 Jahre Support erhalten sollte, damit fielen schlagartig ein gigantischer Teil Geräte weg. Angesichts dem 5+ Jahres Support von Apple ist das absolut erbärmlich. Weiterer Punkt wäre eine ordentliche Kamera und ein OLED Display, Annehmlichkeiten wie eine Klinkenbuchse waren mir dagegen ziemlich egal.

Letztlich bin ich dann am Google Pixel 3 hängen geblieben, von allen Android Geräten gehören die Pixel Geräte zu den ganz wenigen die instant mit Android Updates monatlich versorgt werden für mindestens 3 Jahre, die exquisite Kamera rundet das Paket noch ab. Oft hab ich in der Vorab-Recherche davon gelesen wie toll auch ein Stock-Android gegenüber den oft genutzten Hersteller Oberflächen und “Bloatware” die mit installiert wird. Kurz überlegte ich auch für ein Huawei Mate 20 Pro, dies war jedoch schlicht zu groß für mich und die Update-Politik von Huawei gefiel mir auch nicht. Am Ende blieb ich also beim Pixel 3 (Nicht-XL) was von der Größe her gerade so mir passte.

Kaum ausgepackt musste ich erst mal alle meine Medien rüberportieren. Zu dem Zeitpunkt wünschte ich mir das ich einfach, wie bei Apple einfach ein Backup eines älteren Gerätes einspielen konnte und alles wäre gegessen, aber das klappt nicht mal richtig unter demselben Hersteller und zwei Android Geräten. Nach langem hin und her hab ich Musik Playlisten umgewandelt und mit meiner Bilder-Sammlung über SFTP aufs Gerät übertragen. Gleich darauf fiel mir auf das mein Stock Android gar nicht so “Stock” ist wie immer behauptet wird. Google Dienste sind krass stark eingebunden, nicht mal den “Squeeze” (bei dem man das Gerät zusammendrücken kann, um den Google Assistent zu öffnen) konnte ich auf eine andere App legen. Genauso unnütz ist die Stock-Zeit App. Weiterer Unsinn wie Unlimited Speicher für Google Fotos oder die absurd schreckliche Google Music App konnte mir auch erspart bleiben. Blieb mir ein Android 9 Gerät ohne anständige Musik App und direkten Draht zu Google. Weiterhin gibt Google den Pixel Geräten exklusive Features, die sonst kein anderes Gerät bekommt, z. B. die Shazam-esque Musik Erkennung im Lockscreen:

Vielleicht war es eine dumme Idee ein Google Handy zu kaufen, wenn ich sowieso Abstand von Google nehmen wollte, letztlich habe ich mein Pixel 3 soweit angepasst das Google so wenig wie möglich mitbekommt. Ein extrem guter Helfer dafür war unter anderem der F-Droid Store, welcher eine direkte Alternative zum Google Play Store ist und oft einfach qualitativ bessere Apps bietet. Die Entwickler vom F-Droid Store haben es sich zur Aufgabe gemacht Open-Source Apps, ohne Googles mitwissen zu verbreiten, dafür werden alle Apps im offiziellen Repository von F-Droid Entwicklern kompiliert und signiert, Werbung oder Tracker sind dabei explizit nicht erlaubt. Allgemein hat es mich erschreckt, wie viele Android Apps schlicht komplett voll von irgendwelchen Trackern sind, die teilweise in Frameworks standardmäßig implementiert sind.

Ein weiterer Unterschied zu iOS war das einige Apps wie z. B. VLC oder Parceltrack einfach schlechter waren und denen Features gefehlt haben. Andersherum gab es jedoch auch einige Apps die unter Android mehr Umfang haben. Meine Lieblings Reddit App Apollo musste ich auch ersetzen, im Moment hab ich mit Boost für Reddit einen einigermaßen guten Ersatz gefunden. Nach 4 Monaten bleibt immer noch ein bitterer Nachgeschmack von Android, immerhin bin ich mit meinem Pixel 3 ein wenig mehr zufrieden und freue mich auf weitere 3 Jahre bis ich wohl wieder nach Ersatz Ausschau halten werden.

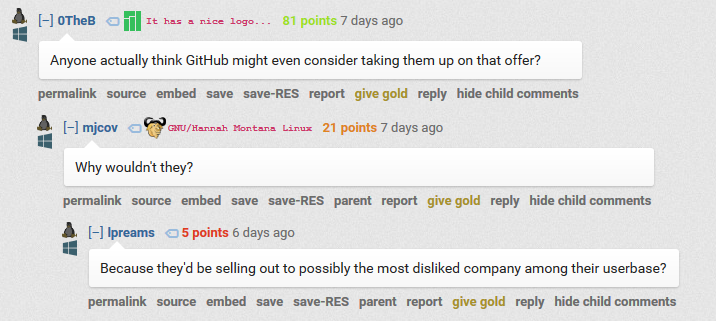

Am 4. Juni 2018 gaben GitHub und Microsoft bekannt das Microsoft GitHub aufgekauft haben für 7,5 Mio. $. Während man sich bei GitHub freut, wandern mehrere tausende Nutzer auf andere Git Plattformen wie GitLab oder hosten sogar ihre Git Web-Oberfläche selber mit Gitea, Gogs oder eben GitLab selber.

Vielen GitHub Nutzern stößt die Ankündigung sauer auf, vor allem auch auf Reddit:

Die Realität sieht jedoch anders aus, vor einigen Jahren hat Microsoft angefangen sich mehr mit Open-Source auseinander zu setzen und ihre GitHub Repositories gehören zu den beliebtesten:

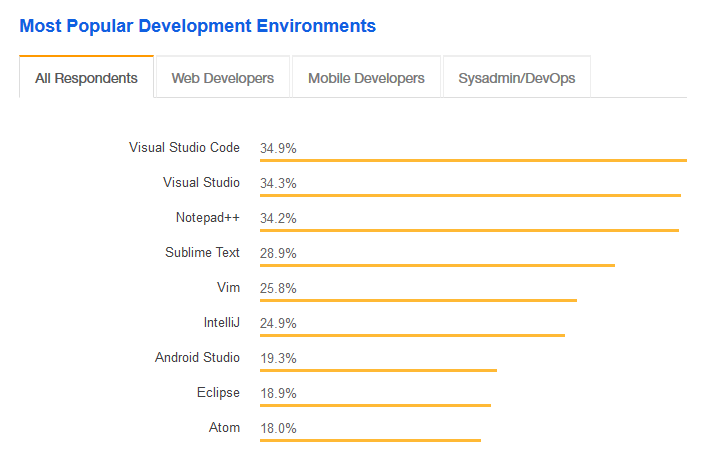

Vor allem auch Visual Studio Code gilt inzwischen als beliebterer Editor als Atom.io (welcher von GitHub gepusht wurde) und Visual Studio (ohne “Code”) gehört auch immer noch zu den ganz Großen.

Trotzdem bleibt ein fader Beigeschmack, Microsoft nutzt beispielweise bis heute ein proprietäres Format für ihre Office Dokumente.

Aber immerhin hat die Debate über GitHub nun etwas gutes: Man schaut sich jetzt endlich nach Alternativen um, hosten eventuell seine Git Repositories auf mehreren Servern statt das Monopol nur GitHub zu überlassen. Zu diesem Zweck habe ich interessante Vor- und Nachteile der beliebtesten Git Web-Oberflächen zusammengetragen:

GitHub

+ Am beliebtesten

+ Der Status Quo

+ Kanban Projekt Board

+ Static Webhosting via GitHub Pages

+ Snippets

+ Signierte Commits via GPG key

+ Merge Approval System

- Nicht Open-Source

- Keine privaten Repos ohne zu bezahlen

- Ändern regelmäßig ihr Interface

- Kein einfacher Import aus anderen Git Oberflächen

- Keine Möglichkeit der Authentifizierung bei Import über Git oder SVN Server

GitLab

+ Gratis private Repositories

+ Open-Source in der Community Edition

+ Selbst hosten ohne Probleme möglich

+ Gratis Paid membership für Schulen und big Open-Source Maintener

+ CI (Continuous integration) Tests

+ Kanban Projekt Board

+ Static Webhosting via GitLab Pages

+ Einfacher Import aus anderen Git Oberflächen wie GitHub, BitBucket, Google Code und self hosted Gitea oder GitLab

+ Snippets

+ Signierte Commits via GPG key

+ Code Quality Checks

+ Merge Approval System

- Teilweise etwas träge

- Releases maximal 2 MB pro Datei

- Benötigt viele Ressourcen in der Self hosted Variante

Bitbucket

+ Gratis private Repositories

+ CI Tests

+ JIRA Support

+ Kanban Board via Trello Integration

+ Snippets

+ Einfacher import aus GitHub, SourceForge und CodePlex